В современных условиях стремительного развития цифровых технологий и роста объемов сетевого трафика обеспечение стабильной, эффективной и качественной работы сетей становится приоритетной задачей. Усложнение сетевых архитектур, внедрение облачных вычислений, Интернета вещей (IoT) и сетей пятого поколения (5G) требует более надежных и гибких решений для управления сетевыми ресурсами. В этой связи качество обслуживания (QoS) выступает важнейшим компонентом сетевой инфраструктуры, способствующим приоритизации трафика, оптимизации ресурсов и обеспечению бесперебойной работы критически важных приложений.

В условиях цифровой трансформации центры обработки данных играют ключевую роль в хранении, обработке и управлении огромными объемами информации. Такие центры представляют собой специализированные объекты, где размещаются многочисленные серверы, системы хранения данных и сетевое оборудование. Это позволяет эффективно обрабатывать, хранить и распределять данные в больших масштабах [1, с. 732-794; 2, с. 468-473]. Эти инфраструктурные комплексы оказывают критическое влияние на широкий спектр сервисов, включая облачные вычисления, аналитику больших данных и корпоративные приложения, которые сегодня составляют основу бизнес-процессов и цифровых услуг [3, с. 7-18; 4; 5, с. 293-314].

Современные сети центров обработки данных представляют собой высокоинтегрированные и сложные системы, созданные для передачи больших объемов данных с высокой скоростью и эффективностью [6; 7, с. 189-200; 8, с. 92-99; 9, с. 63-74]. Они обеспечивают стабильное взаимодействие между различными устройствами и системами, поддерживая необходимый поток данных для множества приложений и услуг. Нарушение работы таких сетей может привести к значительным сбоям, что отрицательно сказывается на непрерывности и производительности бизнеса [10, с. 63-74; 11, с. 39-50].

Поддержание стабильности в таких системах предполагает применение стратегий, направленных на обеспечение надежной и бесперебойной работы сети и ее компонентов. Для этого применяются такие методы, как избыточность, балансировка нагрузки и механизмы отказоустойчивости [12, с. 1912-1926; 13, с. 49-60; 14, с. 821-830; 15, с. 225-238; 16, с. 85-96]. Избыточность заключается в создании дополнительных маршрутов передачи данных, что позволяет минимизировать риск сбоев. Балансировка нагрузки равномерно распределяет трафик между серверами или сетевыми путями, избегая перегрузок отдельных элементов. Отказоустойчивость, в свою очередь, обеспечивает продолжение работы системы даже при сбое оборудования или программного обеспечения благодаря автоматическому переключению на резервные ресурсы и репликации данных.

Управление качеством обслуживания (QoS) [17, с. 6-27; 18, с. 6-14] является важным элементом сетевого администрирования и включает методы для приоритизации и оптимизации сетевых ресурсов. QoS позволяет добиться надежной и эффективной передачи данных, отвечающей специфическим требованиям различных приложений. Для этого применяются механизмы классификации трафика [19, с. 281-286], формирования [20, с. 482-501], контроля [21, с. 90-109], а также использования очередей и предотвращения перегрузок [22; 23, с. 45-51; 24, с. 1-14; 25, с. 47-57].

Современные достижения в области программно-определяемых сетей (SDN), виртуализации сетевых функций (NFV) и методов искусственного интеллекта (ИИ) открывают новые перспективы для совершенствования механизмов QoS. Эти технологии позволяют адаптировать управление сетью к меняющимся требованиям пользователей и условий эксплуатации, создавая более масштабируемые и интеллектуальные решения.

Настоящая статья посвящена анализу существующих проблем внедрения QoS, изучению перспектив ее развития и оценке возможностей применения передовых технологий для повышения качества обслуживания в современных сетевых системах. Исследование направлено на выявление ключевых факторов, влияющих на производительность сети, и разработку рекомендаций для их учета при построении и эксплуатации сетевой инфраструктуры. Полученные результаты могут быть полезны как для научного сообщества, так и для практиков в области сетевой инженерии.

Центр обработки данных (дата-центры)

Центры обработки данных (дата центры) представляют собой специализированные объекты, где размещаются разнообразные вычислительные ресурсы, включая серверы, системы хранения данных и оборудование для обеспечения сетевого взаимодействия. Их основное предназначение – централизованное хранение, обработка и управление значительными объемами информации. Такие центры играют ключевую роль в поддержке широкого спектра приложений и услуг, включая облачные технологии, анализ больших данных и корпоративные ИТ-решения [26, с. 2939-2965]. Благодаря высоким стандартам безопасности, надежности и масштабируемости центры обработки данных обеспечивают бесперебойное выполнение критически важных бизнес-операций, составляя основу современной цифровой инфраструктуры. Их использование охватывает такие области, как веб-хостинг, электронная почта, финансовые транзакции и научные исследования.

Сетевые системы в центрах обработки данных формируют сложную структуру соединений, которая связывает все устройства и компоненты, обеспечивая их эффективное взаимодействие и надежную передачу данных [27, с. 640-656; 28, с. 23-33]. Эти сети создаются с учетом необходимости обработки значительных объемов трафика при минимальной задержке и максимальной надежности. Обычно они разделены на несколько уровней: уровень ядра, уровень агрегации и уровень доступа. Каждый из этих уровней выполняет определённые задачи, способствуя бесперебойному потоку данных [10, с. 63-74; 29, с. 892-901; 30, с. 161-172]. Уровень ядра отвечает за высокоскоростные соединения с большой пропускной способностью, уровень агрегации собирает данные из различных точек доступа, а уровень доступа обеспечивает подключение серверов и других устройств к сети.

Современные технологии, такие как программно-определяемые сети (SDN) [31, с. 14-76] и виртуализация сетевых функций (NFV) [32, с. 90-97], активно внедряются для повышения гибкости, эффективности и удобства управления сетями центров обработки данных.

Стабильность сети в контексте центров обработки данных определяется способностью поддерживать надежную и непрерывную производительность на протяжении времени. Она предполагает, что сеть должна адаптироваться к изменению нагрузки без возникновения значительных простоев или ухудшения рабочих характеристик. Одной из ключевых проблем является наличие сетевых помех, которые возникают из-за различных факторов, таких как перекрестные помехи между кабелями и конкуренция между рабочими нагрузками за доступ к общим сетевым ресурсам [33, с. 201-213; 34; 35]. Эти факторы могут привести к таким последствиям, как потеря данных, увеличение задержек и общее снижение производительности сети [36, с. 1-13; 37, с. 1-32].

В условиях работы центра обработки данных минимизация сетевых помех становится критически важной задачей для обеспечения надежного функционирования приложений и сервисов. Основные стратегии для устранения подобных проблем включают использование экранированных кабелей, правильную организацию заземления, а также создание физического разделения между кабелями и электронным оборудованием. Дополнительно, применение современных методов управления сетью, таких как механизмы качества обслуживания (QoS), позволяет приоритизировать важнейший трафик, уменьшая негативное влияние помех на работу сети.

Эффективное управление стабильностью сети и устранение помех являются важными аспектами работы современных центров обработки данных. Эти элементы играют ключевую роль в поддержании необходимого уровня производительности, надежности и эффективности, соответствующих растущим требованиям цифровой эпохи. Использование передовых технологий и передового опыта позволяет организациям обеспечить стабильность работы центров обработки данных и удовлетворять изменяющиеся потребности пользователей и приложений.

Качество обслуживания (QoS)

Качество обслуживания (QoS) является ключевым понятием в сетевой инженерии, охватывающим технологии и методы управления сетевыми ресурсами для обеспечения эффективной обработки различных типов трафика. QoS позволяет отдавать приоритет определенным потокам, что особенно важно для критически важных сетевых сервисов. Основная цель QoS заключается в поддержании высокой производительности для таких приложений, как видеоконференции, VoIP (передача голоса по интернет-протоколу) и онлайн-игры, даже в условиях сетевой перегрузки, которая может негативно сказаться на пользовательском опыте и выполнении критически важных операций [38, с. 1239-1258].

Механизмы QoS обеспечивают контроль над такими параметрами сетевой производительности, как пропускная способность, задержка, джиттер и потеря пакетов. За счет их регулирования QoS способствует эффективному функционированию приложений с высокими требованиями к производительности сети даже в сложных условиях.

Механизмы QoS включают несколько основных элементов:

- Классификация трафика. Этот процесс включает идентификацию и категоризацию сетевого трафика на основе заранее определенных критериев, таких как тип приложения, пользователь или данные. После классификации трафиком можно управлять в соответствии с его приоритетом.

- Формирование трафика. Данный метод контролирует объем данных, поступающих в сеть, предотвращая ее перегрузку. Это достигается за счет задержки пакетов, превышающих установленный лимит скорости, сглаживания всплесков трафика и обеспечения равномерного потока.

- Управление политиками. Политики QoS регулируют скорость входящего трафика, отбрасывая или помечая пакеты, превышающие установленные ограничения. Это помогает предотвратить перегрузку сети и поддерживать соответствие трафика установленным требованиям.

- Организация очередей и планирование. Различные типы трафика распределяются по очередям в зависимости от их приоритета. Алгоритмы планирования, такие как Weighted Fair Queuing (WFQ) и Priority Queuing (PQ), определяют порядок обработки пакетов. Высокоприоритетный трафик получает преимущество перед низкоприоритетным, что обеспечивает критически важным приложениям необходимую пропускную способность.

- Предотвращение перегрузки. Механизмы, такие как Random Early Detection (RED), активно управляют сетевой нагрузкой, отслеживая состояние трафика и упреждающе отбрасывая пакеты при обнаружении риска перегрузки [39, с. 397-413]. Это помогает сохранять стабильную производительность сети и минимизировать риски критических сбоев.

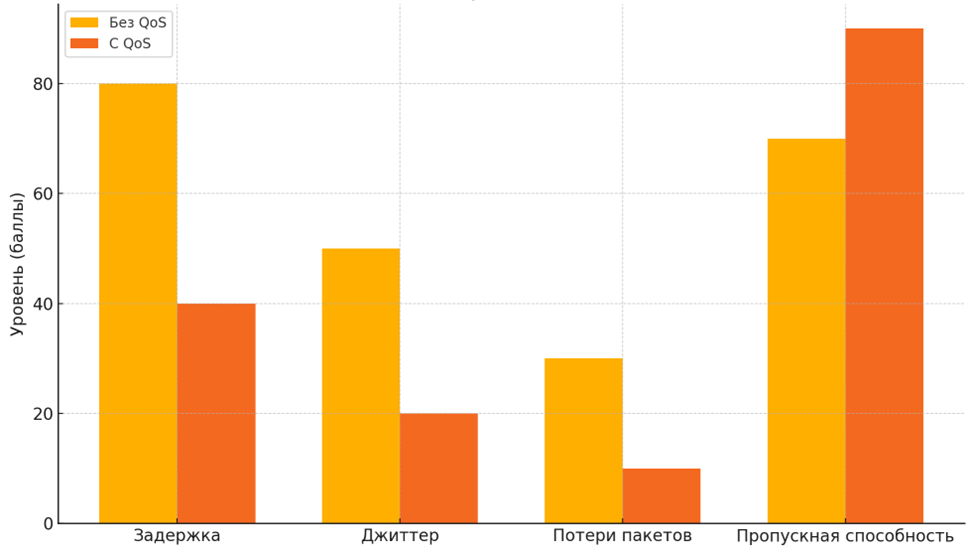

Перед внедрением QoS сети часто сталкиваются с проблемами высокой задержки, джиттера и потерь пакетов, что особенно критично для приложений реального времени, таких как видеоконференции и VoIP. Для иллюстрации улучшений, которые QoS может привнести, была проведена оценка ключевых метрик производительности сетей с использованием механизмов QoS и без них. Результаты наглядно показывают, что QoS значительно снижает задержки и потери пакетов, одновременно улучшая пропускную способность, что подтверждает важность применения QoS в современных сетевых архитектурах (рис. 1).

Рис. 1. Влияние QoS на производительность сети (составлено автором на основании источника [39, с. 397-413]

Протоколы

IEEE 802.1Q

Известный как протокол тегирования VLAN, стандарт IEEE 802.1Q предоставляет механизм для добавления информации о виртуальной локальной сети (VLAN) в кадры Ethernet. Он включает поле приоритета, которое позволяет задавать уровень важности для различных VLAN и связанных с ними данных. Традиционный Ethernet, созданный для общей передачи данных, не удовлетворяет требованиям современных приложений из-за использования недетерминированного метода управления доступом CSMA-CD, что может приводить к непредсказуемым задержкам. Для устранения этих недостатков проводится оценка производительности стандартного Ethernet (IEEE 802.3) и усовершенствованных методов, использующих приоритизацию трафика (IEEE 802.1Q), в условиях различной сетевой нагрузки [40, с. 956-961].

Исследования включают анализ таких показателей, как пропускная способность, задержка и джиттер, при использовании простых концентраторов, стандартных коммутаторов и коммутаторов с поддержкой приоритета. В экспериментах используется сеть, включающая станции реального времени и рабочие станции, генерирующие трафик с распределением Пуассона при уровнях нагрузки от 10% до 60%. Результаты демонстрируют значительное улучшение производительности при использовании коммутаторов с поддержкой приоритетов. Эти устройства эффективно снижают джиттер и задержки отклика, особенно в условиях высокой загрузки сети, что делает их подходящими для промышленных приложений и процессов реального времени.

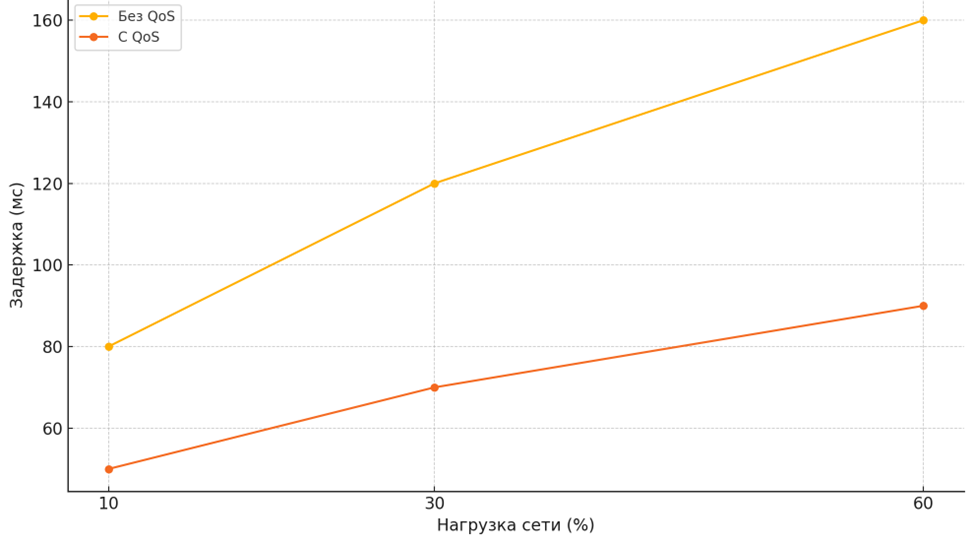

С увеличением сетевой нагрузки задержка и джиттер становятся критическими проблемами для работы приложений. Применение стандарта IEEE 802.1Q позволяет значительно улучшить показатели задержки, что особенно заметно при высокой загрузке сети. Диаграмма (рис. 2) показывает сравнительный анализ задержки при разных уровнях нагрузки с использованием и без использования QoS, подтверждая эффективность внедрения данного стандарта для поддержки сетей в условиях интенсивного трафика.

Рис. 2. Задержка при различных уровнях нагрузки сети (составлено автором на основании источника [40, с. 956-961]

Интегрированные услуги (IntServ)

Архитектура Integrated Services (IntServ) обеспечивает гарантированное качество обслуживания (QoS) для отдельных потоков данных, что отличает её от агрегированных методов, таких как Differentiated Services (DiffServ). IntServ использует протокол RSVP (Resource Reservation Protocol) для резервирования полосы пропускания для конкретных сеансов. Каждый маршрутизатор на пути сохраняет информацию о состоянии потока, что позволяет точно управлять ресурсами, но снижает масштабируемость системы. IntServ наиболее подходит для приложений, где важны строгие гарантии полосы пропускания и минимальной задержки, таких как видеоконференции и VoIP [41].

IntServ направлена на расширение возможностей Интернета для предоставления как услуг реального времени, так и не реального времени, чтобы удовлетворять потребности современных приложений, включая телеконференции, дистанционное обучение и распределённое моделирование. Архитектура представляет собой значительный шаг в направлении адаптации Интернета к требованиям новых приложений, обеспечивая справедливое и эффективное использование сетевых ресурсов.

Кодовая точка дифференцированных услуг (DSCP)

Поля DSCP в заголовке IP позволяют маршрутизаторам классифицировать трафик и принимать решения о приоритетах обработки на основе заданного типа обслуживания (ToS). Это более детализированная версия IP Precedence, обеспечивающая больше уровней приоритизации трафика.

Differentiated Services (DiffServ) представляет собой масштабируемую модель QoS, которая устраняет ограничения IntServ и RSVP, особенно в условиях крупных сетей, таких как магистральные сети Интернета [42, с. 255-273]. Вместо управления отдельными потоками DiffServ применяет агрегированный подход, где пакеты маркируются байтом DS, определяющим их приоритет. Это обеспечивает управление ресурсами на уровне всей сети без необходимости обрабатывать каждый поток по отдельности.

Модель DiffServ предлагает несколько подходов, таких как Premium Service и Assured Service. Premium Service обеспечивает выделение фиксированной полосы пропускания для агрегированных потоков, подобно частным каналам связи, а Assured Service, хотя и не гарантирует пропускную способность, обеспечивает высокую вероятность доставки пакетов с высоким приоритетом.

Механизмы DiffServ включают маркировку пакетов, управление поведением на маршрутизаторах и реализацию стратегий управления трафиком. Несмотря на преимущества масштабируемости, успех DiffServ зависит от тщательного проектирования сети, чтобы гарантировать достаточность ресурсов для обработки приоритетного трафика, что остаётся серьёзной задачей для сетевых инженеров.

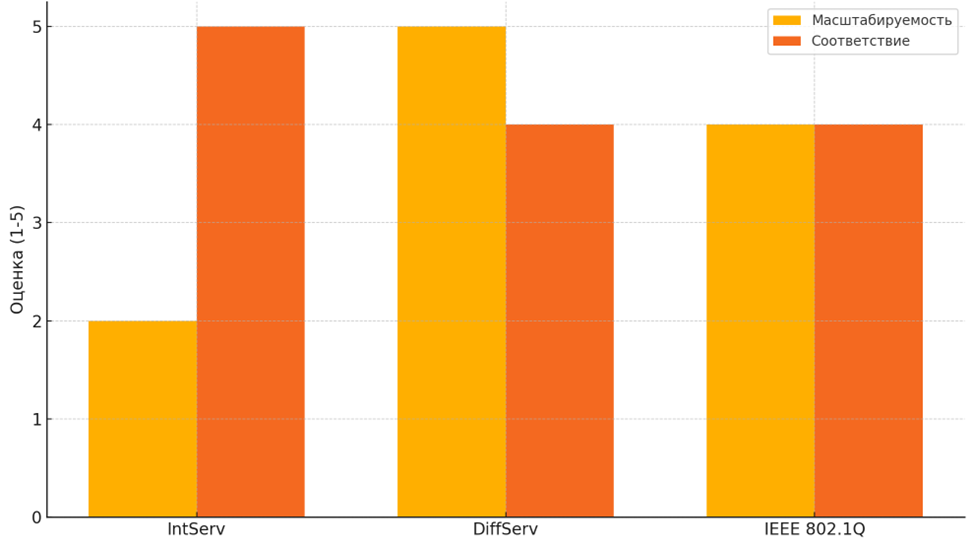

Разные подходы к реализации QoS, такие, как IntServ, DiffServ и IEEE 802.1Q, обладают своими преимуществами и ограничениями. Например, IntServ обеспечивает гарантии на уровне потоков, но плохо масштабируется, тогда как DiffServ предлагает агрегированный подход, более подходящий для крупных сетей. Стандарт IEEE 802.1Q оптимизирует управление трафиком внутри VLAN. Для лучшего понимания их различий представлена сравнительная диаграмма (рис. 3), оценивающая масштабируемость и соответствие каждого метода требованиям современных сетей.

Рис. 3. Сравнение методов QoS (составлено автором на основании источников [40, с. 956-961; 41; 42, с. 255-273]

Проблемы при внедрении QoS

Реализация QoS в сетях сталкивается с рядом вызовов. Одной из ключевых проблем является сложность настройки и управления политиками QoS. Для эффективного внедрения сетевые администраторы должны обладать глубокими знаниями о характере сетевого трафика и специфических требованиях приложений. Это требует значительных временных и интеллектуальных затрат.

Вторая проблема связана с межоперабельностью оборудования различных производителей. Протоколы и механизмы QoS могут существенно различаться у различных поставщиков, что приводит к несовместимостям. Это осложняет обеспечение сквозного QoS в гетерогенных сетевых средах и увеличивает риск ошибок при настройке.

Кроме того, внедрение QoS может вызывать дополнительные задержки и накладные расходы. Процессы классификации, формирования и постановки трафика в очередь требуют значительных вычислительных ресурсов. При неэффективном управлении это может негативно сказаться на производительности сети, увеличивая время отклика и снижая пропускную способность.

Перспективы будущего для QoS в сети

С развитием сетевых технологий значение QoS будет только увеличиваться. Рост использования облачных вычислений, Интернета вещей (IoT) и внедрение сетей пятого поколения (5G) создают новые вызовы для управления трафиком. Эти технологии генерируют разнообразные типы данных с уникальными требованиями, что потребует более интеллектуальных и адаптивных механизмов QoS.

Одной из ключевых технологий будущего станет использование машинного обучения и искусственного интеллекта (ИИ) в QoS. ИИ-ориентированные механизмы смогут анализировать трафик в реальном времени, предсказывать возможные перегрузки и автоматически настраивать политики QoS для оптимизации производительности. Такой подход обеспечит более гибкое и точное управление сетевыми ресурсами.

Дополнительно, переход к программно-определяемым сетям (SDN) и виртуализации сетевых функций (NFV) расширяет перспективы реализации QoS. Эти технологии разделяют управление и передачу данных, что упрощает централизованное управление сетью. Благодаря этому QoS может быть более гибко настроена, что обеспечит эффективное использование сетевых ресурсов и повышение производительности в сложных сетевых средах.

Заключение

Качество обслуживания (QoS) является важным компонентом современных сетевых систем, гарантируя надежность и эффективность передачи данных для различных приложений и услуг. В данной статье проанализированы ключевые подходы к реализации QoS, включая IntServ, DiffServ и IEEE 802.1Q, а также их преимущества и ограничения. Представленные данные подтвердили, что применение механизмов QoS способствует значительному снижению задержки, джиттера и потерь пакетов, одновременно повышая пропускную способность сети.

Особое внимание было уделено проблемам внедрения QoS, включая сложность настройки политик, межоперабельность оборудования различных поставщиков и потенциальные накладные расходы на производительность. Эти аспекты требуют дальнейших исследований и разработки адаптивных решений, которые могли бы минимизировать эти недостатки.

Перспективы развития QoS связаны с интеграцией технологий искусственного интеллекта и машинного обучения, а также переходом к программно-определяемым сетям (SDN) и виртуализации сетевых функций (NFV). Эти подходы открывают возможности для создания более интеллектуальных, масштабируемых и гибких сетей, способных адаптироваться к изменениям трафика в режиме реального времени.

Полученные результаты подтверждают, что QoS остается критически важным элементом для обеспечения надежности и производительности сетей, особенно в условиях внедрения облачных технологий, Интернета вещей (IoT) и сетей 5G. Развитие и совершенствование QoS в ближайшие годы будут играть ключевую роль в удовлетворении требований цифровой инфраструктуры и обеспечении высокого уровня обслуживания пользователей.

.png&w=384&q=75)

.png&w=640&q=75)