Введение

Актуальность разработок и исследований методов и систем как детектирования, так и классификации удалённых объектов на данный момент является крайне высокой. В данной статье не будут учитываться промышленные и научные цели подобных методик. Акцент будет сделан на получении технологического превосходства над противником в ходе проведения Специальной Военной Операции, а именно – для детектирования и классификации удалённых объектов военной техники.

Детектирование в компьютерном зрении – это процесс идентификации и определения расположения объектов на изображении или видеопотоке. Спектр задач технологии включает обнаружение лиц, транспортных средств, пешеходов, символов и других объектов.

Классификация в компьютерном зрении – это присвоение входному изображению предопределённой метки или категории путём определения основного содержания конкретного изображения.

Цель данной работы – выявление физических и программных ограничений, которые могут возникнуть во время разработки системы обнаружения и распознавания сильно удалённых объектов.

1. Детектирование движущихся объектов

Принцип детектирования движущихся объектов на видео основан на сравнении нескольких последовательных кадров. По результатам сравнения определяется, обнаружен ли какой-либо движущийся объект.

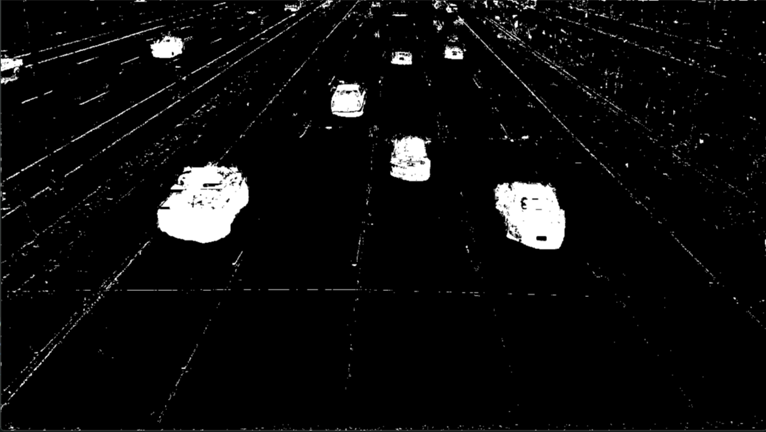

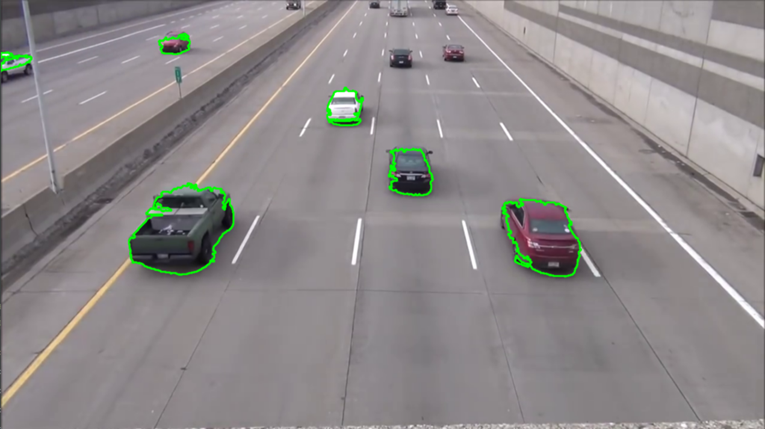

Зачастую, для алгоритмов подобного детектирования не требуется запуск искусственных нейронных сетей, вместо этого можно обойтись двумя относительно простыми методами, использующими простые вычисления. Обнаружение контуров – метод, используемый для идентификации и очерчивания объектов, в сочетании с вычитанием фона, которое выделяет движущиеся объекты на статичном фоне, создает мощный дуэт для обнаружения движущихся объектов в режиме реального времени. Этот подход практичен и эффективен с точки зрения вычислений, следовательно, он подходит для приложений, требующих быстрого и точного обнаружения объектов. Для реализации данного метода отлично подходит OpenCV – библиотека алгоритмов компьютерного зрения, обработки изображений и численных алгоритмов общего назначения с открытым кодом. Подробнее эта технология детектирования (пример работы на рис. 1 и 2) описана в отдельной статье [1].

Рис. 1. Промежуточный этап детектирования

Рис. 2. Итоговый этап детектирования

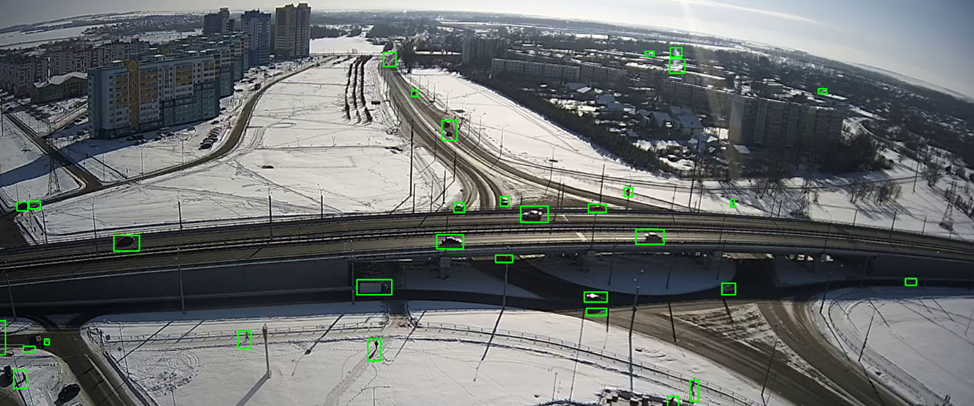

По рекомендациям статьи [1] была написана простая программа /1/, демонстрирующая возможности детектирования с помощью простых алгоритмов. Пример её работы представлен на рисунке 3.

Рис. 3. Реализованное детектирование объектов

При подобном детектировании важно точно настроить значения минимальных воспринимаемых объектов, чтобы отсеять максимальное количество шумов и побочных объектов, не потеряв при этом критически важные объекты. В данном случае воспринимаются как шумы и игнорируются контуры менее 50 пикселей.

Стоит заметить, что в процессе работы программа периодически выдаёт большое количество найденных объектов в местах, где их нет. Возможно, это связано с изменением значительного количества пикселей на изображении самой камерой. Для борьбы с этим эффектом требуется добавить дополнительную фильтрацию шума.

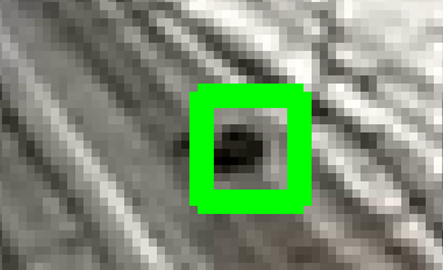

На рисунке 2 представлен один из мельчайших объектов, обнаруженных данным алгоритмом. Его площадь в кадре составляет порядка 60–75 пикселей, он чётко выделяется на фоне дороги и всё же, по данному кадру (рис. 4) визуально сложно причислить его к конкретному классу, для нейронной сети это также будет непростой задачей.

Рис. 4. Один из самых мелких обнаруженных объектов

2. Классификация обнаруженных объектов

Для классификации объектов за редким исключением используются искусственные нейронные сети. При этом в открытом доступе есть предобученные нейронные сети, то есть, данные модели уже обучены на больших наборах данных. Такие модели можно как обучить дополнительно на небольшом количестве данных, специфичных для конкретной задачи, так и не дообучать совсем.

Предобученные модели могут значительно улучшить качество в задачах классификации изображений, особенно в ситуациях, когда отсутствует достаточное количество данных для обучения. Даже если базовая модель не имеет ничего общего с решаемой задачей, она всё равно может оказаться полезной, поскольку уже умеет узнавать самые простые объекты окружающего мира.

В случаях же, если искомый объект похож на машину, но для полноценного обучения недостаточно фотографий, проще использовать модель, которая будет определять объект как машину.

В целом реализация распознавания объектов сильно отличается в зависимости от выбранного алгоритма, модели нейронной сети, требований к скорости и качеству, а самое главное – от доступного аппаратного обеспечения. Пример простой реализации на базе недорогого одноплатного компьютера представлен в следующей статье [2].

В 2021 году опубликована научная статья, посвящённая исследованию влияния масштабирования изображения объекта на вероятность правильного распознавания нейронной сетью YOLOv3. В ходе проведённого исследования получена оценка минимально допустимого размера объекта на изображении. Вероятность правильного распознавания больше 90 процентов обеспечивается только в том случае, если размер объекта на изображении превышает минимально допустимое значение порядка 25–40 пикселей в зависимости от положения объекта в кадре [3, с. 34-37].

Полученные в ходе исследования данные вполне применимы и к современным моделям нейронных сетей, так как сейчас улучшаются скорость работы и обучения, точность же распознавания уже достигла определённого предела.

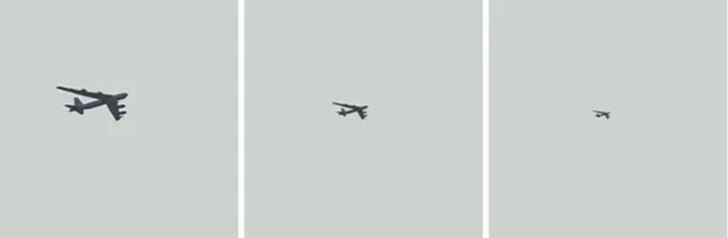

К полученным выводам следует добавить то, что вышеописанное исследование проводилось на объектах, имеющих значительные отличия по форме и изображённых на фоне неба в ясную погоду. В данном случае очертания объектов резко выделялись на однородном фоне (рис. 5).

Рис. 5. Изображение из исследования о точности распознавания

В полевых же условиях классификация объекта будет осложнена неоднородностью фона, различными шумами, бликами и погодными условиями. Также не стоит забывать о возможности применения противником средств маскировки (рис. 6). Исследований точности распознавания замаскированных объектов в открытом доступе найти не удалось.

Рис. 6. Маскировка объекта

3. Исследование разрешения камер

Плотность пикселей на метр (PPM) – это параметр, который используют при проектировании систем видеонаблюдения. Он позволяет подобрать разрешение камеры в зависимости от задачи.

Чаще всего плотность пикселей измеряют по вертикали, но возможно также измерение по горизонтали. Значение параметра зависит от разрешающей способности камеры, размера зоны обзора и того, насколько удалён объект интереса от видеокамеры.

Итак, исходя из предыдущих пунктов сделаем вывод, что для детектирования и распознавания объекта (учитывая препятствующие этому факторы) требуется, чтобы объект был представлен на изображении по самой меньшей мере 60 пикселями.

За реальный размер видимой части условного объекта примем 0,25 м2, что приближённо соответствует грудной фигуре человека (мишень: 50*50 см) или наземному робототехническому комплексу «Лягушка» (длина: 0,75 м, ширина: 0,6 м, высота: 0,38 м).

Возьмём ближайший к 60 (минимальное количество пикселей) квадрат целого числа. Это – 64 (или 8*8), следовательно, (пусть цель квадратная и имеет размеры 0,5*0,5 м) минимальное разрешение должно соответствовать 8 пикселей на 0,5 метра или 16 пикселей на метр (PPM).

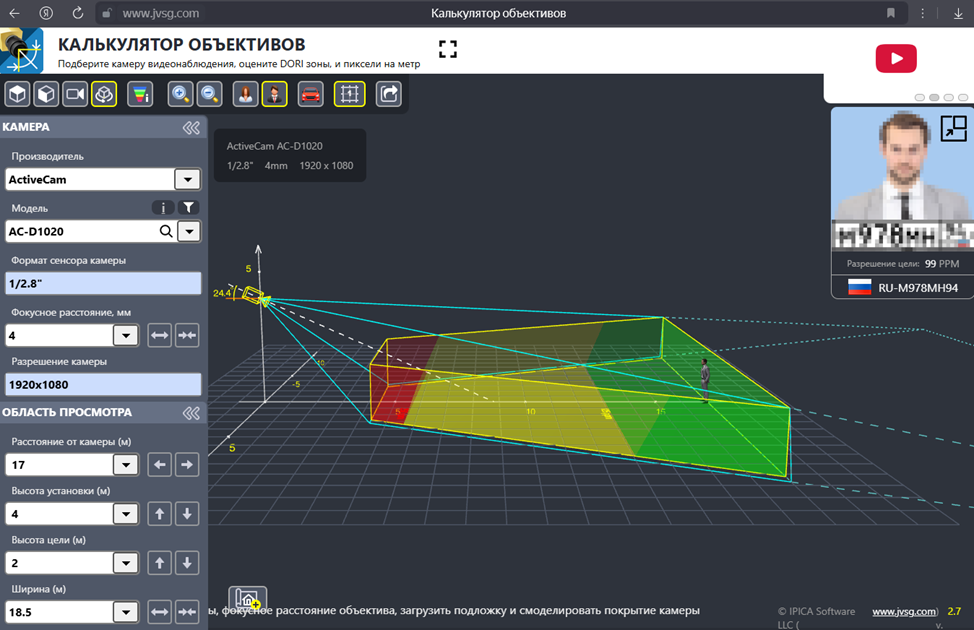

В открытом доступе существуют утилиты, позволяющие рассчитать значение PPM для удалённых объектов. Одной из таких утилит является калькулятор плотности пикселей (объективов). Калькулятор плотности пикселей – это online-утилита, позволяющая подобрать характеристики камеры видеонаблюдения для решения одной из целевых задач – обнаружения, распознавания или идентификации [4]. Данная утилита предоставляет возможность выбора расстояния до объекта, разрешения камеры, её фокусного расстояния, формата сенсора, высоты установки камеры и некоторых других характеристик. Пример работы утилиты представлен на рисунке 7.

Рис. 7. Интерфейс и пример работы калькулятора объективов

Также в утилите есть возможность выбора конкретной модели видеокамеры со всеми доступными настройками конкретного прибора (например, фиксированным разрешением и переменным фокусным расстоянием).

Большинство видеокамер, представленных на сайте данного калькулятора, являются снятыми с производства и их нет в свободной продаже. Но в рамках исследования были выбраны 3 камеры, всё ещё доступные к покупке. Данные устройства выбраны из разных ценовых категорий с целью продемонстрировать важность правильного выбора камеры, а также – некоторые физические ограничения сильного приближения.

Ниже описаны выбранные камеры и их главный параметр в исследовании – фокусное расстояние, которое является переменным, единицы измерения – миллиметры.

ActiveCam AC-TA363IR2 [5]: 2,8, 3,6, 3,7, 4, 6, 8, 12, в таблице представлены: 8 и 12.

Amatek AC-IS506ZAX [6]: 2,7, 2,8, 3,6, 3,7, 4, 6, 8, 12, 13,5, в таблице: 12, 13,5

Panasonic WV-X6533LN [7]: 4,25, 6, 8, 12, 25, 50, 75, 100, 125, 150, 170, в таблице: 25, 50, 75, 100, 125, 150, 170.

Для наглядности с помощью калькулятора была рассчитана плотность пикселей в зависимости от типа камеры и её фокусного расстояния (табл.).

Таблица

Сравнение возможностей различных видеокамер

№ | Видеокамера | Цена, руб | Фокусное расстояние, мм | Расстояние до объекта, м | Ширина кадра, м | PPM |

1 | ActiveCam AC-TA363IR2 [5] 1280*720 формат сенсора: 1/4 | ≈3 300 | 8 | 150 | 66,5 | 19 |

200 | 88,7 | 14 | ||||

12 | 200 | 59,9 | 21 | |||

300 | 89,9 | 14 | ||||

2 | Amatek AC-IS506ZAX [6] 2880*1616 формат сенсора 1/2.8 | ≈ 10 700 | 12 | 300 | 128,2 | 22 |

450 | 192,4 | 15 | ||||

13,5 | 450 | 172,3 | 17 | |||

500 | 191,5 | 15 | ||||

3 | Panasonic WV-X6533LN [7] 1920*1080 формат сенсора 1/2.8 | ≈ 384 600 | 25 | 500 | 107,6 | 18 |

600 | 129,1 | 15 | ||||

50 | 600 | 65 | 30 | |||

1200 | 129,9 | 15 | ||||

75 | 1200 | 88 | 22 | |||

1750 | 128,3 | 15 | ||||

100 | 1750 | 97,8 | 20 | |||

2250 | 125,7 | 15 | ||||

125 | 2250 | 98,2 | 20 | |||

2850 | 124,4 | 15 | ||||

150 | 2000 | 73,3 | 26 | |||

2500 | 91,6 | 21 | ||||

3000 | 110 | 17 | ||||

170 | 2000 | 66,3 | 29 | |||

2500 | 82,9 | 23 | ||||

3000 | 99,5 | 19 |

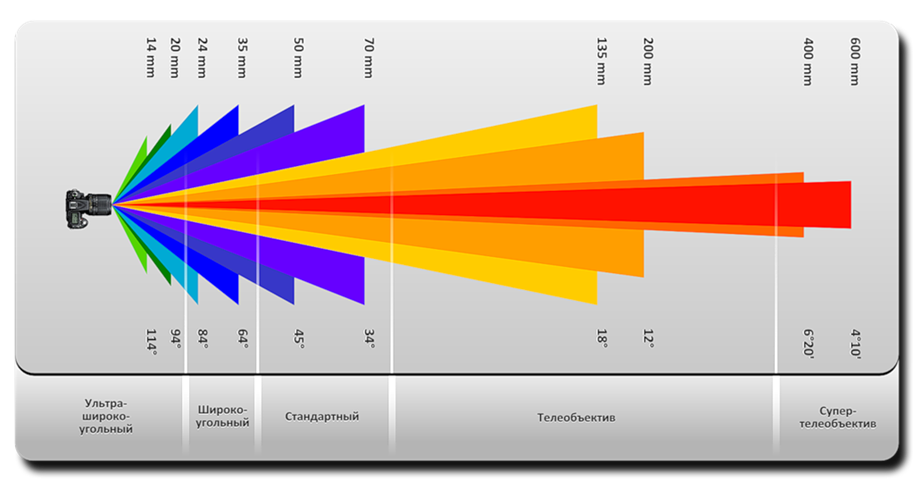

Из исследования следует логичный вывод, что с увеличением фокусного расстояния сильно сужается видимая область. Иначе говоря, чтобы увеличить плотность пикселей, не увеличивая сенсор камеры, придётся сжать область захвата изображения. Подтверждения данному выводу можно найти в открытом доступе (рис. 8).

Рис. 8. Зависимость угла обзора и дальности камеры от фокусного расстояния

Для подобной задачи немного лучше подошла бы видеокамера Panasonic AW-UE100WEJ с разрешением 3840*2160 и максимальным фокусным расстоянием 98,9, но её стоимость на текущий момент составляет уже более миллиона рублей. Но даже с такой камерой остаётся главная проблема: чем больше приближение, тем уже угол обзора.

При фокусном расстоянии 98,9, ширина области обзора более, чем в 17 раз меньше расстояния до объекта, что ставит под сомнение целесообразность подобного применения.

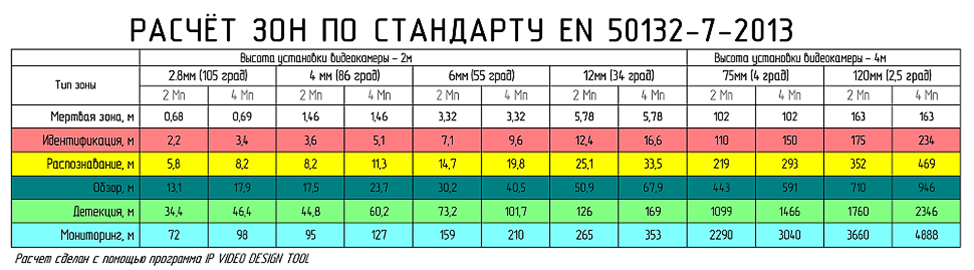

Также в открытом доступе была найдена статья с подобным проведённым исследованием в программе «VIDEO DESIGN TOOLS». Хотя зоны видимости камер сильно зависят также от разрешения и от типа сенсора, на рисунке 9 представлена более наглядная и простая для понимания таблица корреляции возможностей видеокамер от их фокусного расстояния [8].

Рис. 9. Расчёт зон видимости камеры в зависимости от фокусного расстояния

Заключение

В начале работы ставилась следующая цель: выявление физических и программных ограничений, которые могут возникнуть во время разработки системы обнаружения и распознавания сильно удалённых объектов. Цель работы считаю достигнутой. Выяснено приблизительное минимальное количество пикселей, необходимое для детектирования объекта с помощью общедоступных методов. Также выявлена корреляция между плотностью пикселей и областью, захватываемой камерой с определённым типом сенсора. Непосредственно нейросетевое распознавание объектов затронуто достаточно поверхностно, однако для полноценного отчёта необходимо проводить практические испытания различных моделей.

Статья написана в рамках исследования возможности разработки автоматизированной системы, способной на значительном расстоянии обнаруживать объекты военной техники и классифицировать их как свои или противника.

Для разработки полноценной эффективной системы необходимо проведение большего количества как теоретических, так и практических исследований. Однако, данная статья может стать отправной точной в создании тестового макета подобной системы и запуска программы детектирования объектов. Данное исследование также представляет ценность в контексте ограничений выбора аппаратной составляющей в зависимости от конкретных задач. Например, что для опытного образца системы слежения за областью определённой ширины и на определённом удалении, следует выбирать камеру с минимальными характеристиками формата сенсора и фокусного расстояния.

В рамках поиска похожих исследований была найдена статья 2013 года [9], в которой производится анализ и сравнение непосредственно математических методов детектирования удалённых объектов: Лукаса – Канаде, шаблонов движений, сдвига среднего, Виолы – Джонса, непрерывно адаптирующегося сдвига. Данная статья рекомендуется к ознакомлению.

Приложение

/1/

import cv2

import numpy as np

# Инициализация видеопотока

video_path = 'video.mp4'

cap = cv2.VideoCapture(video_path)

# Создание объекта для фона

backSub = cv2.createBackgroundSubtractorMOG2()

while True:

# Чтение следующего кадра

ret, frame = cap.read()

if not ret:

break

# Применение модели фона для выделения движущихся объектов

fg_mask = backSub.apply(frame)

# Применение морфологических операций для удаления шума

kernel = cv2.getStructuringElement(cv2.MORPH_ELLIPSE, (5, 5))

fg_mask = cv2.morphologyEx(fg_mask, cv2.MORPH_CLOSE, kernel)

fg_mask = cv2.morphologyEx(fg_mask, cv2.MORPH_OPEN, kernel)

# Нахождение контуров движущихся объектов

contours, _ = cv2.findContours(fg_mask.copy(), cv2.RETR_EXTERNAL, cv2.CHAIN_APPROX_SIMPLE)

for contour in contours:

if cv2.contourArea(contour) < 50: # Игнорируем маленькие контуры

continue

(x, y, w, h) = cv2.boundingRect(contour)

cv2.rectangle(frame, (x, y), (x + w, y + h), (0, 255, 0), 2) # Рисуем рамку вокруг движущегося объекта

# Отображение результата

cv2.imshow("Motion Detection", frame)

key = cv2.waitKey(30) # Уменьшение задержки для более плавного отображения

if key == ord('q'): # Выход при нажатии 'q'

break

# Освобождение ресурсов

cap.release()

cv2.destroyAllWindows()

.png&w=384&q=75)

.png&w=640&q=75)