С развитием технологий искусственный интеллект всё активнее используется в процессе заключения и исполнения сделок. От чат-ботов и интеллектуальных помощников до полностью автономных систем – ИИ способен вести переговоры, принимать решения, исполнять обязательства. Однако, в отличие от традиционных субъектов гражданского права ИИ не обладает ни сознанием, ни волей, что вызывает сомнения в легитимности совершаемых им действий и нравственной оценке подобных сделок.

Использование искусственного интеллекта становится привычным элементом современных экономических и правовых отношений. Развитие цифровых платформ позволяет применять технологии ИИ для ведения переговоров, оценки предложений, анализа контрактов и исполнения договорённостей. Несмотря на очевидные преимущества автоматизации процессов, возникают серьёзные трудности юридического и морального порядка.

Сегодняшняя практика показывает активное применение ИИ-технологий в различных сферах экономики, включая финансы, страхования, ритейл и торговлю недвижимостью. По оценкам экспертов, около половины крупных компаний мира уже используют ИИ-решения для оптимизации бизнес-процессов. Эта тенденция усиливается благодаря преимуществу эффективности и скорости обработки больших объёмов данных.

Согласно ст. 2 ГК РФ, участниками гражданских правоотношений могут быть физические и юридические лица, а также публично-правовые образования. ИИ не охватывается данным перечнем, что юридически исключает его самостоятельное участие в сделке. Однако, на практике ИИ может осуществлять функции, аналогичные действиям представителя или агента [1]. Так, в постановлении Пленума ВС РФ № 25 от 23.06.2015 «О применении судами некоторых положений раздела I части первой ГК РФ» отмечается, что юридически значимые действия должны совершаться субъектом, обладающим правоспособностью и дееспособностью. ИИ такими качествами не обладает, что вызывает сомнения в действительности сделок, заключённых при его участии. Возникает дилемма: кто несёт ответственность за действия ИИ – разработчик, пользователь, собственник? Если ИИ заключает сделку с нарушением интересов контрагента, возникает вопрос об этичности такого взаимодействия. Проблема обостряется в случае с автономными ИИ, действия которых невозможно в полной мере предсказать.

Стоит отметить, что ИИ-системы могут использовать персонализированные данные для манипулирования поведением контрагента, предлагая условия, к которым тот не пришёл бы без внешнего влияния. Это затрагивает принципы добросовестности и свободы воли, закреплённые в ст. 10 и 421 ГК РФ. ИИ, обученные на предвзятых данных, могут осуществлять дискриминационные практики при выборе контрагента или установлении условий сделки. Такие действия нарушают как этические нормы, так и антимонопольное законодательство (например, ст. 10 Закона о защите конкуренции № 135-ФЗ). В качестве примера приведём дело «Loomis v. Wisconsin» (США). Хотя это дело не связано напрямую со сделками, оно демонстрирует опасность «чёрного ящика» в алгоритмах. Суд признал, что использование алгоритма COMPAS при вынесении приговора не нарушает прав обвиняемого несмотря на то, что принцип работы алгоритма оставался закрытым. В контексте сделок это может означать отсутствие у контрагента возможности оценить справедливость предложенных ИИ условий.

Если ИИ оказывает влияние на волеизъявление человека через поведенческие триггеры, речь может идти о нарушении ст. 178 ГК РФ (заблуждение) или даже о ст. 179 ГК РФ (принуждение к сделке). Обратимся к международному опыту по данному поводу. В США рассматривалось дело Amazon Alexa, где была подана жалоба на Alexa оформляла заказы без чёткого подтверждения со стороны пользователя. В условиях отсутствия явного волеизъявления со стороны лица чьё имя использовалось, такие действия могут быть оспорены как заключённые без воли сторон.

Согласно ст. 307 ГК РФ, обязательства должны исполняться надлежащим образом. Использование ИИ создаёт риски нестабильного исполнения в силу возможных системных сбоев или непредвиденного поведения алгоритма. Этический вопрос здесь заключается в допустимости передачи принятия ключевых решений системам с недостаточной степенью предсказуемости.

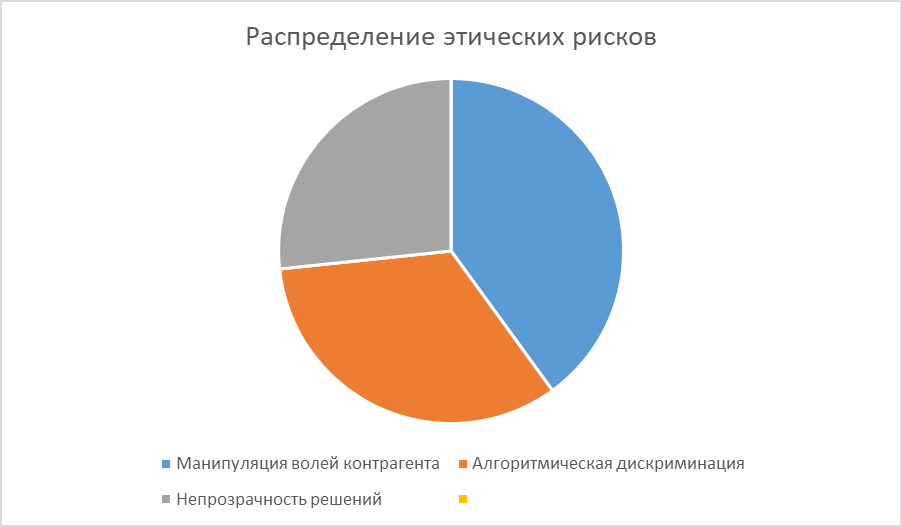

Рис.

На диаграмме показано распределение основных этических рисков, возникающих при заключении сделок с участием ИИ.

ИИ- системы могут использовать персонализированные данные для манипулирования поведением контрагента, предлагая условия, к которым тот не пришёл бы без внешнего влияния, что затрагивает принципы добросовестности и свободы воли, закреплённые в ст. 10 и 421 ГК РФ.

ИИ, обученные на предвзятых данных, могут осуществлять дискриминационные практики при выборе контрагента или установлении условий сделки. Такие действия нарушают эти этические нормы, так и антимонопольное законодательство (например, ст. 10 Закона «О защите конкуренции № 135-ФЗ) [2]. Приведём практический пример, а именно дело «Loomis v. Wisconsin» (США). Хотя это дело не связано напрямую со сделками, оно демонстрирует опасность «чёрного ящика» в алгоритмах. Суд признал, что использование алгоритма COMPAS при вынесении приговора не нарушает прав обвиняемого несмотря на то, что принцип работы алгоритма оставался закрытым. В контексте сделок это может означать отсутствие у контрагента возможности оценить справедливость предложенных ИИ условий [5].

Если ИИ оказывает влияние на волеизъявление человека через поведенческие триггеры, речь может идти о нарушении ст. 178 ГК РФ (заблуждение) или даже о ст. 179 ГК РФ (принуждение к сделке). В качестве примера рассмотрим дело Amazon Alexa. В США рассматривались жалобы на то, что Alexa оформляла заказы без чёткого подтверждения со стороны пользователя. В условиях отсутствия явного волеизъявления со стороны лица чьё имя использовалось, такие действия могут быть оспорены как заключённые без воли сторон.

Согласно ст. 307 ГК РФ, обязательства должны исполняться надлежащим образом. Использование ИИ создаёт риски нестабильного исполнения в силу возможных системных сбоев или непредвиденного поведения алгоритма. Этический вопрос здесь заключается в допустимости передачи принятия ключевых решений системам с недостаточной степенью предсказуемости.

Говоря о международном опыте и рекомендациях руководящих принципах OECD по ИИ (2019), OECD подчёркивает необходимость прозрачности, подотчетности и уважения к правам человека при разработке и применении ИИ. Al Act вводит категории риска и устанавливает требования к «высокорисковым» ИИ-системам [3]. Для ИИ, участвующего в заключении сделок (особенно в финансовом или юридическом спектре), предполагается высокая степень регулирования [4].

В рамках данного исследования представляется, что будут логичны и обоснованы следующие пути решения вышеназванных проблем:

- Правовое закрепление статуса ИИ: возможно введение юридической фикции «электронного агента», аналогичной концепции электронного лица, обсуждаемой в Европейской комиссии.

- Повышение прозрачности алгоритмов: включение обязанности раскрывать логику принятия решения при заключении сделок.

- Аудит и сертификация ИИ: обязательная проверка ИИ-систем, участвующих в переговорах и заключении договоров.

- Ответственность разработчиков и пользователей: закрепление солидарной и субсидиарной ответственности в случае ущерба, причинённого ИИ при заключении сделки.

Российское законодательство пока не предусматривает специальной регламентации участия ИИ в совершении сделок. ГК РФ рассматривает лишь субъекты, обладающие сознательной волевой способностью действовать самостоятельно и нести ответственность за последствия своих поступков.

Вместе с тем современные судебные прецеденты показывают, что подобные ограничения постепенно преодолеваются. Например, дела о неправомерном поведении виртуального помощника голосового ассистента или программного робота могут ставить под сомнение традиционное понимание участника договора исключительно субъектов гражданского права.

ИИ уже сегодня трансформирует традиционные принципы взаимодействия сторон в гражданском обороте. Однако, этические дилеммы, возникающие при его участии в сделках, требуют как нормативного, так и ценностного осмысления. Юридическая неопределённость в вопросах субъектности, добросовестности и ответственности должна быть преодолена путём адаптации механизмов к новым технологическим реалиям.

.png&w=384&q=75)

.png&w=640&q=75)