Актуальность исследования

В условиях стремительного роста вычислительных платформ, обладающих экстремальными требованиями по производительности, надёжности, энергопотреблению и масштабу, появляется насущная потребность в особых алгоритмических подходах, выходящих за рамки традиционной практики. Например, переход к системам эксафлопс-уровня ставит ряд принципиально новых задач: резкое увеличение числа вычислительных ядер и параллельных узлов, ограниченная пропускная способность памяти и сети, а также возрастающая частота аппаратных ошибок.

В этой ситуации классические алгоритмы становятся узким местом: коммуникационные задержки и обмен данными начинают доминировать над вычислительной нагрузкой, требования к энергоэффективности и отказоустойчивости выходят на передний план.

В то же время в литературе отмечается, что для таких систем требуется именно «редкая» или экзотическая алгоритмика – методы, которые либо редко применяются, либо имеют узкую область использования, либо требуют специальных архитектурных условий.

Следовательно, построение систематической таксономии таких редких алгоритмических техник становится актуальной задачей: она позволит структурировать знания, определить и классифицировать подходы, повысить их применимость и выявить перспективы внедрения в реальных системах с экстремальными требованиями.

Цель исследования

Целью данного исследования является создание систематизированной таксономии редких алгоритмических техник, применимых к системам с экстремальными требованиями по производительности, надёжности и энергоэффективности, а также определение методологических принципов их отбора, классификации и практической оценки.

Материалы и методы исследования

В качестве источников использованы открытые публикации IEEE, ACM Digital Library, SpringerLink, базы данных TOP500, Green500, а также репозитории OpenAlex, arXiv, Crossref и Zenodo.

Методологическая основа построена на стандартах PRISMA-2020 (для систематизации научных данных) и ACM CCS 2012 (для классификации терминов). Применялись методы системного и сравнительного анализа, Roofline-моделирование, контент-анализ научных публикаций, а также метрики межэкспертной согласованности (коэффициент κ Коэна). Практические данные по производительности и энергоэффективности систем экзафлопс-уровня использовались для калибровки критериев редкости и применимости алгоритмов.

Результаты исследования

Современная теория и практика сверхпроизводительных и критически важных систем сходятся на том, что ключевые ограничения задаются не только пиковыми FLOPS, но и энергопотреблением, пропускной способностью памяти/сети и предсказуемостью времени отклика.

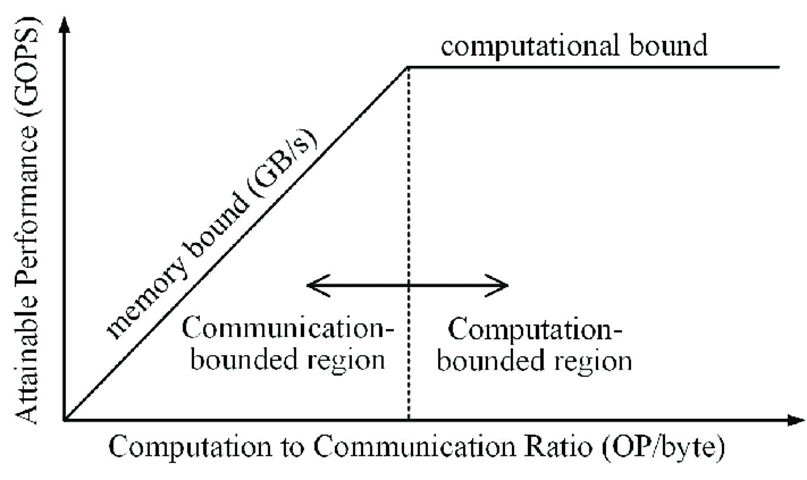

Для формализации верхних границ производительности в условиях узкого «горла» памяти используется модель Roofline, связывающая достижимую производительность с операционной интенсивностью (операции/байт) и «потолками» пропускной способности памяти и вычислительного пика. По сути, положение ядра на диаграмме определяется тем, ограничен ли алгоритм памятью или вычислениями, а повышение эффективности достигается либо ростом интенсивности (повторное использование данных), либо снижением трафика к DRAM [13].

Для более наглядного понимания принципа взаимодействия вычислительных и коммуникационных ограничений приведена упрощённая схема Roofline-модели, представленная на рисунке 1.

Рис. 1. Модель Roofline: взаимосвязь вычислительных и коммуникационных ограничений [5]

Энергетика базовых операций задаёт фундаментальные пределы для «экстремальных» систем: по сводным оценкам Хоровица (45 нм) добавление целых чисел на 32 бита стоит порядка 0,1 пДж, умножение – ~3 пДж; для 32-битных операций с плавающей точкой сложение – ~0,9 пДж, умножение – ~3,7 пДж, а обращение к SRAM/DRAM на порядки дороже вычисления. Отсюда вытекает общий принцип: «вычислять дешевле, чем перемещать данные», что делает редкие техники, минимизирующие движение данных, особенно ценными [6].

Теория масштабирования задаёт вторую опору классификации. Закон Амдала ограничивает ускорение долей неизбежно последовательной работы, тогда как закон Густафсона показывает рост эффективной производительности при масштабировании размера задачи; оба закона сегодня трактуются как разные формы одной зависимости и корректируются для многоядерных кристаллов с учётом «стоимости» ресурсов. Для систем с экстремальными требованиями это означает, что редкие техники, уменьшающие последовательные участки или повышающие операционную интенсивность, обладают непропорционально высоким эффектом при больших p.

Наконец, для жёсткого реального времени и функциональной безопасности нормативная база (IEC 61508 и производные EN 50128 для железнодорожной отрасли) требует предсказуемости и доказуемости временной корректности, где «жёсткие» системы не допускают пропуска дедлайна, а «мягкие» допускают контролируемые нарушения качества обслуживания. Концепция «изящная деградация» предписывает управляемое снижение качества вместо катастрофического отказа – важная предпосылка для алгоритмов адаптивного ухудшения точности под дедлайн/энергобюджет.

В совокупности эти модели и стандарты формируют каркас таксономии: «редкими» в практическом смысле становятся техники, которые целенаправленно оптимизируют движение данных под Roofline-потолки, уменьшают последовательные «узкие места» по Амдалу, стабилизируют время отклика под нормативы реального времени и управляют деградацией качества под ограничениями энергии и памяти. В таблице 1 приведены показатели систем и «энергетическими ценами» операций, которые обосновывают выбор таких техник.

Таблица 1

Характеристики лидирующих суперкомпьютеров (разработка автора на основе [14])

№ | Система | Страна | HPL Rmax | Энергоэффективность (GFLOPS/Вт) |

1 | El Capitan | США | 1 742 EFlop/s (1 742 000 PFlop/s) | ≈ 60,3 GFLOPS/Вт |

2 | Frontier | США | 1 353 EFlop/s (1 353 000 PFlop/s) | – |

3 | Aurora | США | 1 012 EFlop/s (1 012 000 PFlop/s) | – |

4 | Fugaku | Япония | 442,01 PFlop/s | – |

Эти данные демонстрируют, что даже у лидеров существенная доля энергобюджета уходит на память и коммуникации, а не на арифметику, что напрямую согласуется с Roofline-анализом и «энергетическими ценами» операций.

С теоретической стороны, классические работы по Roofline уточняют, что максимальная производительность ядра ограничена либо «скатом» памяти (наклон, равный пропускной способности памяти), либо «потолком» пиковых FLOPS. Добавление «потолков» в виде векторизации, ILP и ограничений шины ещё сильнее дисциплинирует проектирование алгоритмов: например, перенос вычислений в область более высокой операционной интенсивности (через блокировки, повторное использование тайлов, фузинг ядер) даёт больший выигрыш, чем линейное увеличение FLOPS. Эти выводы подтверждаются практикой HPC-центров, где публикуемые метрики Green500/TOP500 показывают, что лидеры добиваются прогресса не только «сырой» мощностью, но и инженерией данных и сетей.

Методика построения таксономии строится как воспроизводимый систематический процесс, включающий поиск и отбор источников по правилам PRISMA-2020, экстракцию признаков и кодирование, валидацию (в том числе межэкспертную), формирование и публикацию машинно-читаемой таксономии. Подход PRISMA-2020 предписывает фиксировать поток записей от идентификации до включения/исключения с прозрачными причинами исключений; официальные материалы содержат контрольные списки и шаблоны блок-схем, которые рекомендуется применять и к обзорам в области информатики и инженерии [11].

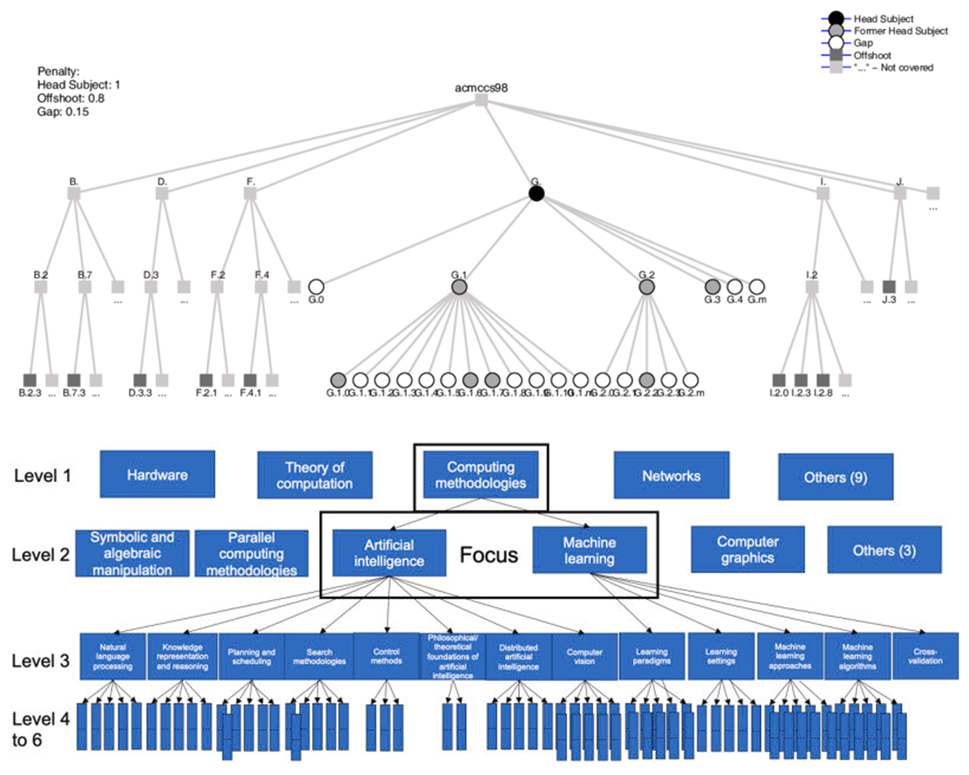

Для классификации и терминологической нормализации целесообразно опираться на ACM Computing Classification System (CCS) как на полииерархическую онтологию, используемую в цифровой библиотеке ACM; верхние уровни CCS служат ориентиром при формировании основных ветвей таксономии и привязке терминов «редких техник» к признанным рубрикаторам (рис. 2). Иерархичность CCS подчёркивается как в официальном описании 2012-й версии, так и в визуализациях топ-уровней предметных областей [15].

Рис. 2. Визуальные представления иерархий и рубрик ACM-CCS, применимые на этапе нормализации терминов и выведения фасетов [9]

Практическая воспроизводимость методики обеспечивается использованием открытых библиографических источников и API (табл. 2). OpenAlex предоставляет открытый доступ к научной библиографической базе через свободный REST-API (до 100 000 запросов в сутки на пользователя), arXiv поддерживает публичный API для поиска и получения метаданных препринтов, Crossref REST API раскрывает метаданные, лицензии, ссылки на фулл-тексты и идентификаторы (в т. ч. ORCID), а Zenodo автоматически регистрирует DOI (через DataCite) при публикации материалов и предоставляет REST-API для депозита версий и файлов.

Таблица 2

Открытые источники и сервисы для воспроизводимого обзора и публикации таксономии (разработка автора на основе [3, 4, 12])

Платформа/ресурс | Тип доступа | Ключевые возможности для методики | Отдельные особенности |

OpenAlex | Открытый REST-API | Поиск и выгрузка записей (работы, авторы, организации), фильтры, снапшоты | Лимит по умолчанию до 100000 API-запросов/сутки; рекомендуется указывать e-mail в запросах |

arXiv | Публичный API | Метаданные препринтов, поиск/линкование | Документация и рекомендации по использованию, условия использования API |

Crossref | Публичный REST-API | Метаданные, лицензии, ссылки на полные тексты, Crossmark, ORCID | Результаты в JSON; фасетирование и фильтрация |

Zenodo | Веб-интерфейс + REST-API | Депозит данных/кода /таксономий; автоматическая регистрация DOI | Резервирование DOI до публикации; управление версиями |

Для оценки качества и сопоставимости выделяемых признаков применяется двойное независимое кодирование и расчёт межсогласованности экспертов. Наиболее распространённой метрикой является Коэффициент каппа Коэна (κ) для номинальных/категориальных данных, описанный в методических обзорах и биостатистической литературе; при упорядоченных шкалах используют взвешенную каппу. Это обеспечивает проверяемость схемы кодов и устойчивость результатов [8].

При выборе качественных признаков алгоритмических техник (например, «чувствительность к пропускной способности памяти», «детерминированность времени ответа», «энергетическая эффективность») целесообразно соотносить их с признанными моделями качества ИКТ-продуктов, чтобы последующее использование таксономии было совместимо с отраслевыми практиками.

Завершающий этап методики – долговременная сохранность и цитируемость результатов. Практические руководства рекомендуют депонировать таксономию (файлы SKOS/OWL, описание методики, таблицы кодов) и сопутствующие артефакты в общедоступных репозиториях, обеспечивающих версионирование и DOI; Zenodo документирует процесс депозита, структуру записи, типы ресурсов и автоматическую регистрацию DOI через DataCite (включая резервирование DOI до публикации). Это важно для воспроизводимости и повторного использования.

Исходя из многочисленных научных публикаций, можно предложить следующую высокоуровневую структуру таксономии редких алгоритмических техник, применимых к системам с экстремальными требованиями:

- техники оптимизации ресурса (энергии, памяти, сети) – например, приблизительное вычисление, вычисления с деградацией качества;

- техники с нестандартной моделью данных или управления (например, самоорганизующиеся структуры, микроядра, управляемые событиями);

- техники управления временем выполнения и стабильностью (например, жесткие дедлайны, адаптивная деградация качества);

- техники отказоустойчивости, самовосстановления, мультиуровневого планирования – менее описаны, но набирают важность в системах реального времени и аэрокосмических приложениях.

В таблице 3 приведены примеры редких техник и ключевых признаков их применения.

Таблица 3

Примеры редких алгоритмических техник и их основные характеристики (разработка автора на основе [1, 2])

Название техники | Описание | Основная цель |

Снижение точности, усечение | Методика допускает уменьшение точности вычислений или данных ради повышения скорости/энергоэффективности | Энергосбережение, ускорение, уменьшение ресурса памяти |

Редкие ветви | Алгоритмы, вдохновлённые живыми системами: растения, грибы, бактерии, др. | Неклассические алгоритмы оптимизации, адаптации |

Метаэвристика | Алгоритм локального поиска с памятью запретных шагов | Улучшение качества решений при сложных задачах оптимизации |

Для оценки пригодности выделенных редких техник крайне важна проверка их эффективности и применимости, как с точки зрения теоретических моделей, так и практических измерений. Например, в исследовании о распределённых методах с разреженной коммуникацией выполнен сравнительный анализ: при увеличении вероятности передачи p методы второго порядка показывали лучшую производительность, тогда как при низком p – методы первого порядка. Анализ производительности для прикладных задач HPC показывает, что использование реалистичных приложений, а не простых ядров, значительно изменяет результаты оценки: применение простых бенчмарков даёт завышенные ожидания, тогда как реалистичные характеризуют узкие места (память, коммуникации) точнее [7].

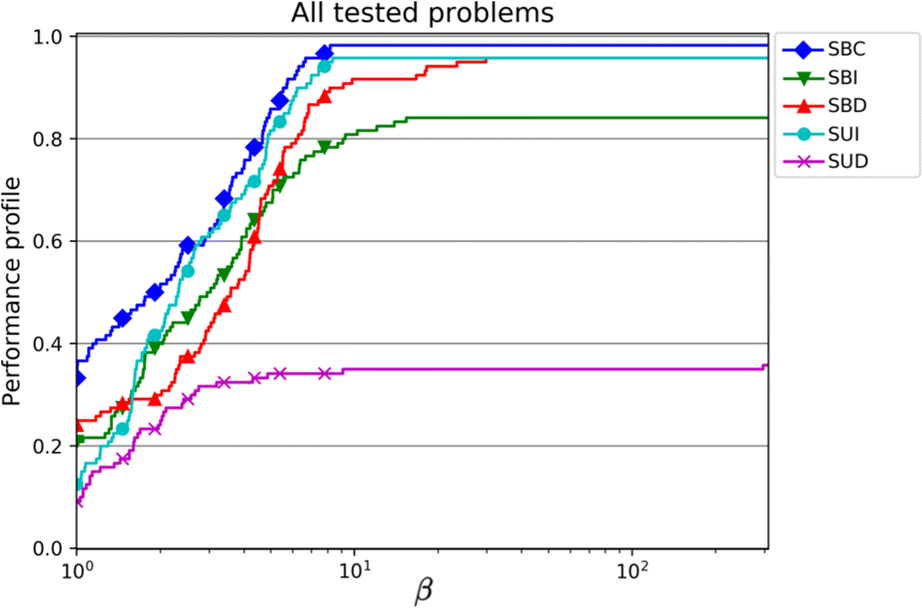

Для анализа эффективности редких алгоритмических техник в литературе широко применяются профили производительности. Метод позволяет сравнивать несколько алгоритмов по совокупности задач, отображая долю задач, решённых с производительностью не хуже, чем β раз от лучшего результата. Такая визуализация даёт интуитивное представление о робастности и средней эффективности каждого метода на множестве тестовых проблем (рис. 3).

Рис. 3. Профили производительности для различных алгоритмов на множестве тестовых задач [10]

На оси X отложен коэффициент β (отношение времени решения к лучшему времени для той же задачи), а по оси Y – накопленная доля задач, решённых с таким или лучшим показателем. Кривые SBC, SBI, SBD, SUI и SUD показывают, как различные алгоритмы ведут себя на всех тестах: чем выше и левее расположена линия, тем метод стабильнее и эффективнее.

Подобные графики часто используются в работах по оптимизации и распределённым методам для оценки редких алгоритмических техник, так как они наглядно отражают компромисс между быстродействием и устойчивостью результатов на широком диапазоне входных данных.

Современные исследования показывают, что редкие алгоритмические техники становятся все более востребованными в контексте систем, предъявляющих экстремальные требования к скорости, энергоэффективности, надежности и устойчивости.

В ближайшие годы их потенциал будет связан с развитием гибридных архитектур – сочетанием классических CPU, GPU, нейроморфных и квантовых процессоров, что требует принципиально новых методов оптимизации потоков данных и вычислений. Особенно перспективным направлением является автоматизация выбора и комбинирования редких техник с помощью инструментов машинного обучения и метаоптимизации. Уже сегодня создаются прототипы фреймворков, способных динамически подбирать оптимальные алгоритмы под конкретную нагрузку.

Важное будущее направление – интеграция редких техник в области энергоэффективных вычислений. Развитие стандартов, подобных Green500, и появление энергетических моделей на уровне алгоритмов (например, Energy Roofline Model) стимулируют поиск решений, минимизирующих энергопотребление без потери точности. Это особенно актуально для экзафлопсных систем, где на каждый ватт мощности приходится ограниченное число операций, и даже минимальное снижение коммуникационных затрат даёт значительный выигрыш.

Перспективной является и сфера киберфизических и автономных систем, где редкие алгоритмы адаптивного управления, прогнозирования отказов и самоисцеления позволяют достигать устойчивости в условиях неопределённости и динамических изменений среды. Такие подходы активно исследуются в робототехнике, авиации и «умных» производственных линиях, где важна непрерывность функционирования при минимальных ресурсных издержках.

Однако наряду с преимуществами следует учитывать и ограничения.

Во-первых, высокая сложность реализации и настройки: большинство редких техник требует глубокого понимания архитектуры системы и специфики вычислительного процесса. Отсутствие готовых библиотек и инструментов затрудняет их внедрение в промышленные решения.

Во-вторых, ограниченная воспроизводимость и верификация – многие алгоритмы разрабатывались в узких исследовательских контекстах и не имеют достаточной экспериментальной базы, подтверждающей их эффективность при изменении архитектуры, объема данных или типа задачи.

В-третьих, риски масштабирования: техники, эффективные в лабораторных условиях, не всегда демонстрируют устойчивость на реальных высоконагруженных кластерах или встроенных системах реального времени.

Наконец, вопрос совместимости с существующими стандартами (например, MPI, OpenMP, CUDA) остаётся открытым: редкие методы нередко нарушают предположения традиционных сред параллелизма и требуют переработки моделей программирования.

Следовательно, дальнейшее развитие редких алгоритмических техник будет определяться их интеграцией в автоматизированные системы проектирования, поддержкой со стороны библиотек открытого кода и расширением экспериментальных исследований на реальных суперкомпьютерах. Главный вызов – переход от «исключений» к формализованным элементам инженерной практики, где редкие алгоритмы станут не экзотикой, а инструментом адаптации вычислений к предельным условиям современного и будущего цифрового мира.

Выводы

Проведённое исследование подтвердило высокую значимость систематизации редких алгоритмических техник для современных и перспективных вычислительных систем, работающих в условиях экстремальных ограничений по производительности, энергопотреблению и надёжности. На основе анализа научных публикаций, стандартов и реальных характеристик суперкомпьютеров экзафлопс-уровня была сформирована структурированная таксономия, позволяющая упорядочить и классифицировать малораспространённые методы по критериям цели, принципа действия и области применения.

Представленная модель объединяет как классические теоретические основания (модели Roofline, законы Амдала и Густафсона, стандарты функциональной безопасности), так и практические механизмы адаптивного управления качеством, энергопотреблением и коммуникациями. В результате выявлено, что редкие алгоритмические техники особенно эффективны при необходимости снижения коммуникационной нагрузки, уменьшения обращений к памяти и достижения предсказуемого времени отклика в реальном времени.

Практическая ценность работы заключается в том, что предложенная таксономия может служить основой для систематического выбора и внедрения оптимальных алгоритмов в высокопроизводительные, распределённые и киберфизические системы. Она также создаёт предпосылки для автоматизации подбора редких техник с применением методов машинного обучения, что открывает возможности для построения самооптимизирующихся вычислительных архитектур.

Дальнейшие исследования целесообразно направить на расширение экспериментальной базы, интеграцию предложенной таксономии с международными базами данных (ACM, IEEE, OpenAlex) и разработку инструментов, обеспечивающих машинно-читаемое описание и верификацию алгоритмических классов. Это позволит превратить редкие алгоритмические подходы из теоретических исключений в устойчивую инженерную практику, обеспечивающую адаптивность, эффективность и устойчивость вычислений в экстремальных условиях.

.png&w=384&q=75)

.png&w=640&q=75)