Актуальность исследования

Актуальность разработки замкнутых AI-инструментов для управления проектами в условиях строгой конфиденциальности обусловлена одновременным ростом сложности инженерных проектов и ужесточением требований к защите корпоративной информации. В современных организациях значительная часть времени специалистов уходит на операционную рутину: поддержание актуальности статусов, подготовку отчётности, ведение перечней задач, поиск сведений в корпоративной документации и согласование регламентных действий. Эти процессы, будучи необходимыми для управляемости проектов, нередко создают «налог на координацию», снижают концентрацию инженера на ключевых задачах и увеличивают стоимость ошибок из-за несвоевременного обновления рабочих артефактов и несогласованности данных между системами.

Одновременно расширение практики применения генеративного искусственного интеллекта в офисных и инженерных процессах сталкивается с ограничениями, типичными для компаний с высоким уровнем информационной безопасности. Использование внешних облачных AI-сервисов затруднено или недопустимо из-за требований по контролю мест хранения и обработки данных, рисков утечек, необходимости аудита доступа, а также обязательств по соблюдению внутренних политик и отраслевых стандартов. В этой связи особую практическую ценность приобретает подход, при котором AI-помощники развёртываются локально или в доверенной корпоративной среде и опираются преимущественно на рабочие материалы и метаданные, формируемые внутри контура. Такая модель позволяет автоматизировать типовые управленческие операции, не нарушая принципов минимизации данных и разграничения доступа, а также обеспечивает трассируемость действий инструмента и воспроизводимость результатов – критически важные свойства для внедрения в строго регулируемых организациях.

Цель исследования

Цель данного исследования – обосновать и описать требования к проектированию и внедрению замкнутого AI-помощника для управления проектами в доверенной/локальной среде, обеспечивающего автоматизацию рутины при соблюдении строгой конфиденциальности за счёт минимизации данных, управляемого доступа и безопасных интеграций.

Материалы и методы исследования

Эмпирической и нормативно-методической базой исследования выступили открытые источники, отражающие требования к архитектуре доверенных корпоративных сервисов, управлению рисками AI и безопасности LLM-приложений

Методологическая основа включала анализ и синтез источников, сравнительный анализ требований разных рамок, сценарное моделирование угроз для LLM и интеграций, концептуальное архитектурное моделирование замкнутого сервиса с разграничением доступа и политик-ориентированным управлением, а также анализ вторичных данных из публичных отчётов для обоснования мер минимизации данных, журналирования, аудита и управляемых изменений компонентов.

Результаты исследования

Внедрение AI-инструментов для управления проектами в организациях со строгой конфиденциальностью начинается не с выбора модели, а с формализации контекста угроз и требований к данным. Практика инцидент-ориентированной аналитики показывает, что значимая доля нарушений безопасности связана с человеческим фактором и социальными техниками, а также с вымогательством и программами-шифровальщиками; к тому же атаки развиваются очень быстро, что уменьшает «окно реакции» и повышает цену ошибок в доступах и процессах. Это важно, потому что любые системы, автоматизирующие проектную рутину (статусы, отчёты, контроль задач), неизбежно становятся частью операционного контура и должны проектироваться как защищаемые корпоративные сервисы.

В таблице 1 приведены количественные наблюдения из публичного отчёта, которые обычно используют как обоснование усиления контроля доступа, обучения и технических мер защиты (включая изоляцию и минимизацию данных) при внедрении любых автоматизирующих инструментов, в том числе AI.

Таблица 1

Ключевые наблюдения и их значение для проектирования замкнутых AI-инструментов управления проектами (разработка автора на основе [3])

Наблюдение | Значение | Где важно для замкнутого AI-инструмента |

Доля нарушений, где присутствовал «человеческий элемент» | 68% | Требуются строгие права доступа, понятные интерфейсы, проверяемые действия и обучение персонала |

Медианное время до клика по вредоносной ссылке после открытия письма | 21 сек. | Нужны превентивные меры (MFA, политики, сегментация), а не только реагирование |

Дополнительное медианное время до ввода данных после клика | 28 сек. | Требуются защищённые потоки аутентификации и минимизация возможностей злоупотребления учётками |

Доля нарушений, связанных с вымогательством/шифровальщиками и иными техниками вымогательства (совокупно) | 32% | Нужны резервирование, сегментация, ограничения латерального перемещения, аудит и план реагирования |

Доля «чистого вымогательства» | 9% | Важно снижать ценность утечки через минимизацию данных и изоляцию контуров |

Доля нарушений, где фигурирует «третья сторона» (расширенная трактовка, включая поставщиков / ПО) | 15% | Важно управлять цепочкой поставок и зависимостями, особенно для компонентов AI и коннекторов |

С точки зрения архитектурного языка кибербезопасности широко применим подход Zero Trust, в котором доверие не предоставляется «по умолчанию», а должно постоянно проверяться; акцент делается на защите ресурсов, управлении идентичностями и доступом, а также ограничении прав до минимально необходимых. Такой подход особенно релевантен замкнутым AI-сервисам, потому что они объединяют доступ к нескольким внутренним системам и могут стать удобной целью для атак с попытками расширения прав и бокового перемещения внутри сети [8].

Отдельный слой требований связан с рисками и управлением жизненным циклом AI. NIST AI RMF 1.0 фиксирует, что управление рисками AI должно быть встроено в практики организации и ориентировано на повышение доверия к системам; среди характеристик «доверенного AI» прямо перечисляются безопасность/устойчивость, подотчётность и прозрачность, интерпретируемость, усиление приватности и управление вредоносными смещениями. Для замкнутых инструментов проектного управления это означает, что нужно заранее определять допустимые источники данных, способы контроля результатов, требования к журналированию и проверяемости происхождения выдачи, а также процедуры изменения/обновления моделей и компонентов [2].

Наконец, при использовании больших языковых моделей и «агентных» сценариев в публичных рекомендациях по безопасности отдельно выделяются типовые классы уязвимостей: быстрая инъекция, небезопасная обработка выходных данных, уязвимости цепочки поставок и другие. Эти риски значимы даже в изолированной среде, потому что входные данные могут содержать атакующие инструкции (например, в тексте документа или комментарии к задаче), а интеграции с внутренними системами могут превратить ошибку модели в действие с реальными последствиями. Поэтому требования к замкнутому AI-помощнику обычно включают политик-ориентированный контроль инструментов, ограничение полномочий и защиту от инъекций на уровне оркестрации и интеграций [5].

Концептуально замкнутый AI-помощник для управления проектами – это корпоративный сервис, развёрнутый локально или в доверенной среде, который помогает выполнять типовые операции проектного управления, опираясь на рабочие материалы и (что принципиально для строгой конфиденциальности) на метаданные и структурированные артефакты, формируемые внутри периметра.

Таблица 2 описывает «что именно» обычно закладывают в концепцию замкнутого AI-помощника на уровне функций и мер контроля, если цель – автоматизировать рутину в управлении проектами и при этом не расширять доступ к чувствительным данным сверх необходимости.

Таблица 2

Концептуальные принципы и меры контроля замкнутого AI-помощника для управления проектами, обеспечивающие строгую конфиденциальность (разработка автора)

Концептуальный элемент | Как проявляется в AI-помощнике для PM | Почему это поддерживает строгую конфиденциальность |

Непрерывная проверка доверия и минимальные привилегии | Доступ помощника ограничен конкретными ресурсами/операциями; решения исполняются через политики | Снижает риск бокового перемещения и «слишком широких» прав внутри сети |

Управление рисками AI по жизненному циклу | Процедуры оценки рисков, контроля качества, журналирование, управляемые изменения | Повышает предсказуемость, подотчётность и контролируемость AI-функций |

Защита от типовых рисков LLM-приложений | Фильтрация/валидация входов, безопасная обработка выходов, ограничения инструментов/действий | Снижает вероятность того, что скрытые инструкции в данных приведут к опасным действиям |

Сокращение «окна атак/реакции» за счёт автоматизации контроля учёток и процедур при жёстких гарантиях валидации и ограничений | Политики MFA, аудит и реакция на аномалии; автоматическое (строго по политикам) блокирование подозрительных входов, отзыв сессий/токенов и ротация ключей; список разрешённых действий, проверка параметров, лимиты и журналирование; для критических операций – подтверждение вторым лицом и безопасный откат | Ускоряет выявление и пресечение компрометации учёток, но одновременно валидация и ограничения предотвращают рост риска из-за автоматизированных ошибочных действий |

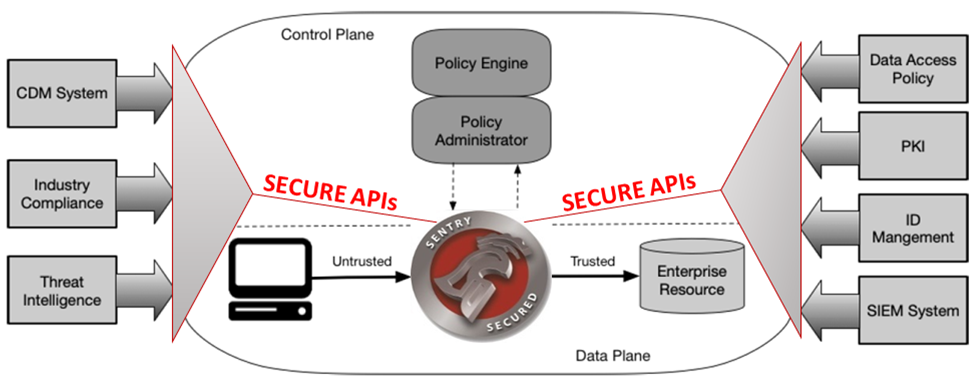

Архитектура замкнутого AI-инструмента в доверенной или локальной среде обычно строится как внутренний сервис, который разделяет «управляющий контур» принятия решений и «контур передачи данных», чтобы минимизировать неявное доверие и сделать обращения к ресурсам управляемыми политиками. В терминах Zero Trust это выражается в наличии логических компонентов, где решения об доступе принимаются в управляющей плоскости, а фактическое установление и прекращение соединений выполняется точкой принудительного применения политики, причём коммуникация политики проходит по отдельной управляющей плоскости, а прикладной трафик – по плоскости данных. На рисунке 1 показана логическая схема компонентов Zero Trust (управляющая плоскость и плоскость данных).

Рис. 1. Схема архитектуры Zero Trust (NIST SP 800-207): разделение управляющей и плоскости данных и применение политик доступа через защищённые API [7]

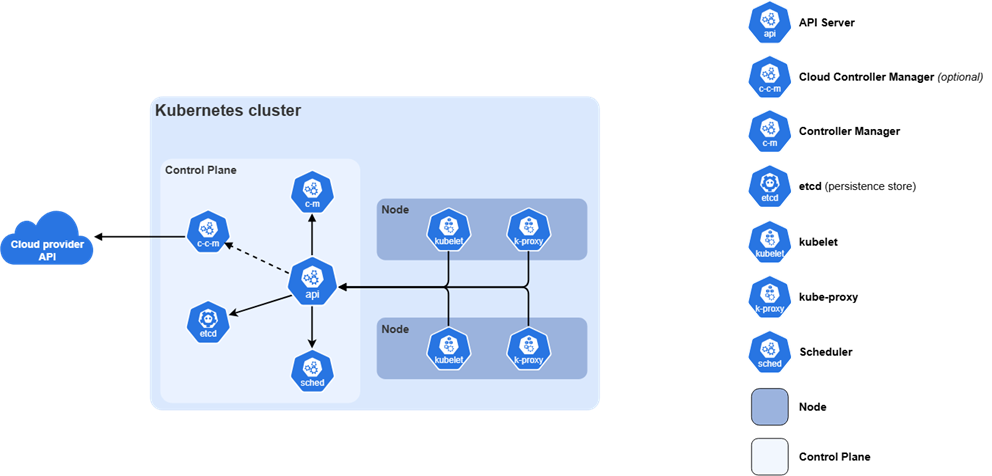

В локальном развертывании практичной опорной платформой часто выступает контейнерная инфраструктура, потому что она обеспечивает воспроизводимость и изоляцию компонентов модели, оркестратора и сервисов доступа к данным в пределах корпоративного контура. Для таких решений важно, что в Kubernetes архитектурно выделяется плоскость управления и рабочие узлы, а также определены ключевые компоненты управления и компоненты узла, которые совместно обеспечивают управляемость, обновляемость и наблюдаемость сервисов (рис. 2). Это повышает воспроизводимость и управляемость эксплуатации «замкнутого AI» как набора корпоративных сервисов: модельный сервер, сервис подготовки индексов, сервисы политик, аудит и шлюзы интеграции становятся отдельными управляемыми компонентами с контролем сетевых взаимодействий и прав. Вместе с тем применение Kubernetes повышает требования к зрелости DevOps-процессов и настройке безопасного контура, поскольку необходимо обеспечить корректное разграничение полномочий, сетевую сегментацию, контроль допуска и регулярное усиление конфигурации кластера.

Рис. 2. Состав компонентов Kubernetes-кластера [4]

Модель доступа и защита по принципу «конфиденциальность по замыслу» для замкнутого AI-помощника строится так, чтобы защита данных была заложена в архитектуру и настройки «по умолчанию». Это означает минимизацию обрабатываемых данных под конкретную цель, строгую сегментацию доступа (по ролям, проектам и контекстам), а также постоянную проверку полномочий при каждом обращении к ресурсам. Доступ предоставляется по принципу наименьших привилегий, все действия сервиса подлежат журналированию и аудиту, а хранение и передача данных защищаются криптографическими механизмами. Дополнительно вводятся организационные меры: регламенты обработки, сроки хранения и удаления, контроль изменений моделей и интеграций, чтобы исключить вторичное использование данных и неконтролируемое расширение доступа.

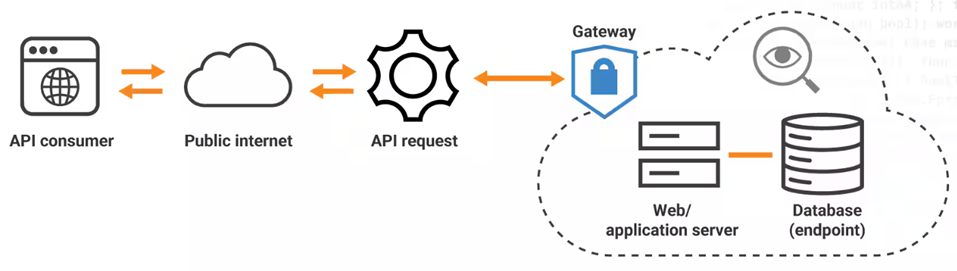

Интеграции замкнутого AI-помощника с внутренними корпоративными системами (трекер задач, базы знаний, репозитории, CI/CD и т. п.) в безопасном дизайне следует рассматривать как API-взаимодействия, где ключевыми становятся корректная авторизация, централизованное применение политик и наблюдаемость. На практике удобной опорой является схема «единая точка входа» через API Gateway, который располагается между клиентами и бэкенд-сервисами и используется для маршрутизации запросов, мониторинга и применения механизмов API-безопасности [6].

На рисунке 3 показан принцип работы API Gateway как точки входа для API-запросов, через которую проще единообразно применять политики и контролировать трафик.

Рис. 3. Принцип работы API Gateway [1]

Безопасный дизайн интеграций также предполагает, что сами коннекторы и их обновления должны жить в управляемом жизненном цикле: изменения версий, конфигураций и зависимостей документируются, проверяются и разворачиваются контролируемо, что хорошо стыкуется с логикой SSDF (Secure Software Development Framework) как источника практик для снижения риска уязвимостей при разработке и сопровождении. В итоге замкнутый AI-помощник разворачивается внутри корпоративного периметра, однако в терминах Zero Trust не получает неявного доверия по признаку «внутренней сети»: доступ и действия определяются политиками и проверяются на каждом сеансе/запросе. Поэтому интеграции становятся формализованными интерфейсами с проверяемыми правилами доступа, а обработка данных ограничивается целями проектного управления и необходимым минимумом рабочих материалов и метаданных.

Наиболее полезны те сценарии, которые снижают нагрузку на инженера от координации и переключения контекста, но при этом не требуют расширенного доступа к чувствительным данным. В первую очередь это подготовка регулярных статус-обновлений по проекту на основе структурированных артефактов: перечня задач, их статусов, сроков, ответственных, зависимостей и зафиксированных блокеров. Такой подход переводит часть синхронизации в асинхронный формат и уменьшает число уточняющих коммуникаций, которые «разрывают» рабочие блоки времени. Дополнительно автоматизируются личные списки дел и планирование: ассистент формирует актуальный перечень задач инженера, отмечает просрочки и риски по срокам, предлагает упорядочивание по приоритетам, а также напоминает о задачах, требующих действий до конкретной даты.

Второй устойчивый набор сценариев связан с подготовкой рабочих материалов по стандартам команд: черновики повестки встреч, шаблонные записи решений и действий (кто делает что и к какому сроку), структурирование итогов в виде короткой записи в базе знаний и обновление страниц статуса проекта. Это снижает долю ручной «канцелярской» работы и повышает единообразие артефактов, что особенно важно в инженерной среде, где цена ошибки в формулировках и ссылках на факты высока. Отдельно выделяются сценарии «быстрого поиска по внутренней документации» в пределах разрешенного контура: индексация и поиск ограничиваются только той документацией, доступ к которой разрешен моделью доступа и которая необходима для задач проектного управления. По возможности ассистент опирается на метаданные (заголовки, идентификаторы, краткие аннотации, ссылки и атрибуты доступа) и возвращает выдержки из утвержденных документов с обязательной привязкой к первоисточнику; полный текст извлекается лишь при явной необходимости и при наличии соответствующих прав доступа.

Чтобы автоматизация реально повышала продуктивность, её эффект целесообразно оценивать через практические показатели процесса разработки: время на подготовку отчётности и поддержание задач, количество возвратов к одним и тем же уточнениям, скорость прохождения типовых согласований, долю времени без переключений контекста, а также показатели скорости и стабильности поставки изменений (в организациях часто используют общепринятый набор инженерных метрик, сопоставимых между командами).

Внедрение замкнутого AI-помощника целесообразно начинать с формализации целей и границ: какие процессы автоматизируются, какие данные допустимы, какие действия запрещены и где требуется подтверждение человека. Далее задаются модель доступа и эксплуатационные требования: роли и минимальные привилегии, сегментация по проектам, защищённое управление сервисными учётными данными, обязательное журналирование и аудит. Затем проводится пилот на ограниченном контуре с измеримыми метриками «до/после», проверкой безопасности интеграций и режимом безопасной деградации. После успешного пилота решение масштабируется по командам через единые регламенты, обучение пользователей, управляемые обновления и регулярные проверки соответствия внутренним политикам.

Выводы

Таким образом, замкнутые AI-инструменты управления проектами целесообразно проектировать как защищаемые корпоративные сервисы, где ключевыми условиями результативности являются минимизация обрабатываемых данных, опора на рабочие материалы и метаданные в изолированной среде, строгая модель доступа (наименьшие привилегии, сегментация, постоянная проверка полномочий), журналирование и аудит, а также безопасный дизайн интеграций через управляемые API-интерфейсы. Такой подход позволяет автоматизировать типовые операции проектной рутины, минимизируя риск нарушения требований конфиденциальности при корректной настройке политик доступа, журналирования и контролируемых изменений, и обеспечивает воспроизводимость и управляемость решения на протяжении жизненного цикла.

.png&w=384&q=75)

.png&w=640&q=75)