Актуальность исследования

В условиях стремительной цифровизации и растущих требований к гибкости и масштабируемости программных решений, микросервисная архитектура (МСА) становится всё более популярной в разработке современных приложений. Её преимущества, такие как независимость компонентов, упрощённая масштабируемость и возможность параллельной разработки, делают МСА привлекательной для многих организаций.

Однако внедрение микросервисной архитектуры влечёт за собой новые вызовы в области тестирования. Традиционные методы, эффективные для монолитных систем, не всегда применимы к микросервисным приложениям. Появляются сложности, связанные с межсервисным взаимодействием, управлением контрактами API, обеспечением согласованности данных и поддержанием стабильности системы при частых обновлениях.

Таким образом, исследование особенностей тестирования в микросервисной архитектуре является актуальным и востребованным, поскольку позволяет разработать эффективные стратегии обеспечения качества в условиях распределённых систем.

Цель исследования

Целью данного исследования является анализ и систематизация особенностей тестирования в проектах с микросервисной архитектурой, а также разработка рекомендаций по эффективному применению различных видов тестирования для обеспечения надёжности и качества программных продуктов.

Материалы и методы исследования

В качестве основного метода исследования использован аналитический обзор научных публикаций, технической документации, отраслевых руководств и материалов с открытых интернет-источников, посвящённых тестированию микросервисной архитектуры. Были изучены практики ведущих ИТ-компаний и рекомендации open-source сообществ по построению автоматизированной стратегии тестирования. Также проведён сравнительный анализ инструментов и подходов с целью выявления их применимости в различных сценариях тестирования.

Материалы исследования включают сравнительные таблицы преимуществ и недостатков микросервисной архитектуры, обзор моделей тестирования, схемы и структурированные рекомендации.

Результаты исследования

Микросервисы – это сервисы для выполнения одной логической задачи. Они могут общаться между собой через API (о чем поговорим дальше), но они не знают о внутреннем устройстве друг друга. Такое взаимодействие между микросервисами называют микросервисной архитектурой, на основе которой создаются приложения с независимыми сервисами, которые развертываются отдельно друг от друга [2].

МСА основывается на следующих ключевых принципах:

- Автономность сервисов: каждый микросервис разрабатывается, развёртывается и масштабируется независимо от других.

- Децентрализация данных: каждый сервис управляет своей собственной базой данных, что снижает связанность между компонентами.

- Организация вокруг бизнес-функций: сервисы строятся с учётом конкретных бизнес-потребностей, обеспечивая лучшее соответствие требованиям пользователей.

- Независимость технологий: разные сервисы могут быть реализованы с использованием различных языков программирования и технологий, что позволяет выбирать оптимальные инструменты для каждой задачи.

Идея микросервисов возникла в результате столкновения разработчиков с проблемами, связанными с монолитными приложениями, которые становились сложными в поддержке и масштабировании по мере их роста [1, с. 53].

При построении архитектуры на основе микросервисов, каждый сервис может работать независимо друг от друга, что обеспечивает большую гибкость и масштабируемость всей системы в целом.

В таблице 1 представлены преимущества микросервисной архитектуры.

Таблица 1

Преимущества микросервисной архитектуры

Преимущество | Описание |

Масштабируемость | Позволяет масштабировать отдельные сервисы независимо, что обеспечивает эффективное использование ресурсов и адаптацию к изменяющимся нагрузкам |

Отказоустойчивость | Сбой одного микросервиса не приводит к отказу всей системы, что повышает общую надежность приложения |

Гибкость разработки | Команды могут выбирать наиболее подходящие технологии и языки программирования для каждого микросервиса, что ускоряет разработку и внедрение новых функций |

Упрощенное обновление | Обновления и развертывания могут выполняться для отдельных микросервисов без необходимости перезапуска всей системы, что снижает время простоя и риски |

Независимость команд | Различные команды могут работать над разными микросервисами одновременно, что улучшает организацию работы и ускоряет выпуск новых версий |

Улучшенное тестирование | Микросервисы можно тестировать отдельно, что упрощает выявление и устранение ошибок, а также повышает качество конечного продукта |

Повышенная безопасность | Изоляция микросервисов ограничивает область воздействия потенциальных уязвимостей, что способствует повышению безопасности всей системы |

Легкость внедрения новых технологий | Микросервисная архитектура позволяет постепенно интегрировать новые технологии и инструменты без необходимости переработки всей системы |

Несмотря на очевидные преимущества микросервисной архитектуры, такие как масштабируемость, гибкость разработки и повышенная отказоустойчивость, её внедрение сопровождается рядом существенных вызовов (табл. 2). Применение микросервисного подхода требует организационных и технических усилий, особенно в контексте управления распределёнными компонентами, обеспечения безопасности и согласованности данных. Эти аспекты обусловливают необходимость более глубокого анализа недостатков микросервисной архитектуры, позволяющего комплексно оценить целесообразность её использования в каждом конкретном случае.

Таблица 2

Недостатки микросервисной архитектуры

Недостаток | Описание |

Сложность управления | Управление множеством независимых сервисов требует дополнительных усилий и инструментов для координации, мониторинга и развертывания |

Повышенные требования к инфраструктуре | Необходимость поддержки и развертывания большого количества сервисов увеличивает сложность инфраструктуры и требует дополнительных ресурсов |

Сложность тестирования | Интеграционное тестирование микросервисов может быть более сложным по сравнению с монолитной архитектурой, особенно при наличии множества зависимостей между сервисами |

Дополнительная нагрузка на сеть | Микросервисы взаимодействуют между собой через сеть, что может привести к увеличению сетевого трафика и задержкам в передаче данных |

Проблемы с целостностью данных | Управление целостностью данных становится сложным из-за распределённой природы микросервисов и необходимости синхронизации данных между различными сервисами |

Повышенные требования к безопасности | Каждое взаимодействие между микросервисами должно быть защищено, что усложняет обеспечение безопасности всей системы и требует дополнительных мер по аутентификации и авторизации |

Сложность отладки и мониторинга | Отладка и мониторинг микросервисной системы требуют сбора и анализа логов и метрик от множества сервисов, что может быть трудоёмким и сложным процессом |

Затраты на разработку и поддержку | Разработка и поддержка микросервисной архитектуры могут потребовать значительных затрат из-за необходимости координации между командами, поддержки различных технологий и обеспечения совместимости между сервисами |

Сравнивая архитектуру микросервисов и сервис-ориентированную архитектуру (SOA), почти невозможно достичь согласия относительно сопоставления этих концепций друг с другом. Добавление термина «прикладной программный интерфейс» (API) в эту смесь делает понимание различий между ними еще более сложным. Некоторые могут сказать, что эти концепции различны, решают свой собственный набор проблем и имеют уникальные рамки. Другие могут быть более сдержанными и говорить, что они достигают схожих целей и работают на одних и тех же принципах. Они также могут сказать, что архитектура микросервисов – это «мелкогранулярная SOA» или что это «правильная SOA» [3].

Основные отличия заключаются в следующем:

- Размер и автономность сервисов: микросервисы более мелкие и автономные по сравнению с сервисами в SOA.

- Протоколы взаимодействия: МСА предпочитает лёгкие протоколы, такие как REST, в то время как SOA часто использует более тяжёлые протоколы, такие как SOAP.

- Децентрализация управления: в МСА отсутствует централизованный брокер сообщений, характерный для SOA.

Микросервисная архитектура предъявляет особые требования к процессу тестирования из-за своей модульности, распределенности и независимости компонентов. В связи с этим, для обеспечения качества и надёжности системы применяются различные виды тестирования, каждый из которых направлен на проверку определённых аспектов функционирования микросервисов:

- Юнит-тестирование (Unit Testing). Проверка отдельных функций и методов внутри микросервиса. Быстрое выполнение и локализация ошибок на ранних этапах.

- Интеграционное тестирование (Integration Testing). Проверяет взаимодействие между сервисами и их зависимостями, включая БД и API.

- Компонентное тестирование (Component Testing). Тестирование микросервиса в изоляции от других, с эмуляцией внешних зависимостей.

- Контрактное тестирование (Contract Testing). Гарантирует, что интерфейсы взаимодействующих микросервисов соответствуют заранее определённым контрактам.

- Сквозное тестирование (End-to-End Testing). Тестирует работу всей системы через пользовательские сценарии.

- Нагрузочное и стресс-тестирование (Load & Stress Testing). Оценивает производительность и устойчивость системы при высокой нагрузке.

- Регрессионное тестирование (Regression Testing). Проверяет, что новые изменения не нарушили существующую функциональность.

- Тестирование производительности (Performance Testing). Измеряет отклик, пропускную способность и использование ресурсов системы.

- Тестирование безопасности (Security Testing). Выявляет уязвимости и проблемы доступа в распределённой среде.

- Тестирование отказоустойчивости (Resilience / Chaos Testing). Проверка реакции системы на сбои отдельных компонентов.

Каждый из этих типов тестирования играет ключевую роль в обеспечении стабильности, безопасности и качества микросервисных систем.

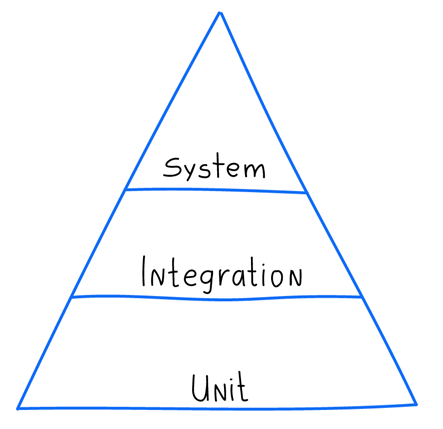

Пирамида тестирования представляет собой концепцию, описывающую соотношение различных видов тестов в проекте (рисунок).

Пирамида состоит из трех уровней [4]:

- Юнит-тесты – нижний и самый широкий уровень пирамиды.

- Интеграционные тесты – средний уровень.

- Системные тесты – самый высокий и узкий уровень пирамиды.

Рис. Пирамида тестирования

Цель такой структуры – обеспечить надёжность системы при оптимальных затратах на тестирование, сосредотачиваясь на автоматизации и раннем выявлении ошибок.

Организация тестирования в микросервисной архитектуре требует учёта специфики распределённых систем, независимости компонентов и их взаимодействия. В таблице 3 представлены ключевые аспекты, влияющие на эффективное тестирование микросервисов.

Таблица 3

Ключевые аспекты, влияющие на эффективное тестирование микросервисов

Аспект | Описание |

Изоляция сервисов | Использование моков и стабов для имитации зависимостей, чтобы тестировать каждый сервис независимо |

Контрактное тестирование | Проверка соответствия API между сервисами через заранее заданные контракты с помощью Pact, Spring Cloud Contract и др. |

Инфраструктура тестирования | Применение Docker, Kubernetes и аналогичных инструментов для создания изолированных и воспроизводимых сред |

Автоматизация (CI/CD) | Включение тестов в конвейеры CI/CD для постоянного контроля качества при каждом коммите (Jenkins, GitLab CI/CD, GitHub Actions и др.) |

Мониторинг и логирование | Внедрение систем централизованного сбора логов и метрик (ELK Stack, Prometheus, Grafana) для анализа поведения сервисов и обнаружения сбоев |

Тестирование на устойчивость | Использование хаос-тестирования (Chaos Monkey, Gremlin) для оценки реакции системы на отказ отдельных компонентов |

Управление тестовыми данными | Генерация, миграция и очистка тестовых данных, а также использование контейнеризированных БД (например, через TestContainers) для обеспечения воспроизводимости |

Параллельность и независимость | Возможность одновременного запуска тестов в разных средах и для разных микросервисов без взаимного влияния |

Эффективная организация тестирования в микросервисной архитектуре требует комплексного подхода, включающего изоляцию сервисов, контрактное тестирование, автоматизацию процессов, мониторинг и управление данными.

Тестирование микросервисной архитектуры требует использования специализированных инструментов и практик, учитывающих особенности распределённых систем. В таблице 4 представлены ключевые инструменты и подходы, применяемые в различных аспектах тестирования микросервисов.

Таблица 4

Инструменты для различных видов тестирования

Тип тестирования | Инструменты |

Юнит-тестирование | JUnit, NUnit, TestNG, pytest, xUnit, Mocha |

Интеграционное тестирование | Postman, Rest-Assured, SoapUI, Docker Compose, TestContainers |

Контрактное тестирование | Pact, Spring Cloud Contract, Hoverfly |

Сквозное (E2E) тестирование | Selenium, Cypress, Robot Framework, Playwright |

Нагрузочное и стресс-тестирование | Apache JMeter, Gatling, Locust, Tsung, ApacheBench |

Тестирование безопасности | OWASP ZAP, SonarQube, Burp Suite |

Хаос-тестирование | Chaos Monkey, Gremlin |

Мониторинг и логирование | Prometheus, Grafana, ELK Stack (Elasticsearch, Logstash, Kibana), Jaeger |

CI/CD и автоматизация | Jenkins, GitLab CI/CD, GitHub Actions, CircleCI, Travis CI |

Управление конфигурацией и инфраструктурой | Docker, Kubernetes, Ansible, Terraform |

Некоторые практики тестирования микросервисов:

- Интеграционные тесты. Проверяют взаимодействие между несколькими микросервисами или их компонентами. Цель – обнаружить проблемы, связанные с интеграцией компонентов, например несовместимость интерфейсов или проблемы с передачей данных.

- Сквозные тесты. Проверяют всю систему целиком, начиная от пользовательского интерфейса до базы данных. Моделируют реальные пользовательские сценарии и взаимодействия с приложением. Цель – убедиться, что все компоненты системы работают вместе корректно и что ПО выполняет свои функции с точки зрения пользователя.

- Компонентные тесты. Фокусируются на тестировании отдельных компонентов системы или микросервисов в изоляции. Могут включать интеграцию с зависимостями, такими как базы данных или внешние API. Цель – проверить функциональность конкретного компонента или микросервиса без учёта других частей системы.

- Системные интеграционные тесты. Гарантируют, что создана правильная система и поведение приложения в интегрированной среде. Тестируют важные пользовательские потоки от начала до конца, чтобы убедиться, что их поведение соответствует ожиданиям.

Эффективное тестирование микросервисной архитектуры требует комплексного подхода, включающего использование специализированных инструментов и практик, адаптированных к особенностям распределённых систем. Применение современных инструментов и стратегий позволяет обеспечить высокое качество и надёжность программных продуктов.

Для внедрения эффективной стратегии тестирования в проектах с микросервисной архитектурой рекомендуется начать с построения пирамиды тестирования, акцентируя внимание на автоматизированных юнит- и интеграционных тестах. Необходимо изолировать сервисы с помощью моков и стабов, внедрить контрактное тестирование для контроля взаимодействия API, и обязательно включать сквозные тесты для проверки бизнес-логики на уровне всей системы. Важно интегрировать тесты в CI/CD-пайплайн, используя инструменты автоматизации (Jenkins, GitLab CI/CD) и управлять тестовыми данными через контейнеризированные БД и миграции. Также рекомендуется внедрять хаос-тестирование для оценки устойчивости к сбоям и обеспечить централизованный мониторинг и логирование (Prometheus, ELK). Стратегия должна предусматривать непрерывный аудит покрытия тестами, адаптацию практик под распределённые команды и регулярный пересмотр рисков.

Перспективы тестирования в микросервисной архитектуре напрямую связаны с развитием автоматизации, внедрением ИИ-решений для анализа качества, а также усилением безопасности в распределённых системах. В ближайшие годы ожидается рост значимости контрактного тестирования, расширение практики «shift-left» (раннее тестирование на стадии разработки), а также интеграция хаос-инжиниринга в стандартные пайплайны CI/CD.

Выводы

Таким образом, эффективность тестирования микросервисных приложений напрямую зависит от способности адаптировать процесс к распределённой и многокомпонентной структуре системы. Универсальные стратегии, применимые к монолитным приложениям, оказываются недостаточными при работе с МСА. Наиболее эффективными являются подходы, обеспечивающие тестирование в изоляции, автоматизацию на всех этапах CI/CD, использование контрактов для обеспечения совместимости API, и реализация сквозных E2E-проверок бизнес-логики. Дополнительно важно организовать хаос-тестирование, мониторинг и управление тестовыми данными. На основе проведённого анализа сформулированы практические рекомендации по построению системы тестирования, соответствующей требованиям надёжности и масштабируемости. Перспективы развития включают внедрение ИИ-аналитики в процесс тестирования, расширение контрактных практик и дальнейшую интеграцию хаос-инжиниринга.

.png&w=640&q=75)