Актуальность исследования

Актуальность исследования обусловлена растущим спросом на эффективные методы обработки и анализа больших объемов данных в современном бизнесе и науке. В эпоху цифровизации данные становятся ключевым активом организаций, и способность быстро и точно извлекать, трансформировать и загружать эти данные для аналитических целей прямо влияет на конкурентоспособность и инновационный потенциал.

Apache Airflow представляет собой мощный и гибкий инструмент, который позволяет автоматизировать сложные ETL-процессы, обеспечивая высокую степень контроля и видимости рабочих процессов данных. С учетом его возрастающей популярности и широкого применения в различных отраслях, понимание основ и базовых принципов работы с Apache Airflow становится важным навыком для специалистов в области обработки данных.

Кроме того, знание Apache Airflow открывает перед инженерами и аналитиками новые возможности для реализации более сложных и масштабируемых проектов по работе с данными. В контексте быстро развивающихся технологий и увеличивающихся объемов данных статья подчеркивает значимость автоматизации ETL-процессов и предоставляет актуальные знания и практические рекомендации для их эффективного исполнения.

Цель исследования

Целью исследования является представление основных понятий и архитектурных особенностей Apache Airflow новичкам, разъясняя его ключевые компоненты, такие как направленные ациклические графы (DAGs), операторы, исполнители и командный интерфейс (CLI).

Через демонстрацию примеров и предоставление пошаговых руководств, исследование стремится обогатить профессиональные навыки читателей, повысить их осведомленность о значении автоматизации в аналитике данных и представить Apache Airflow как мощный инструмент для оптимизации ETL-процессов. Таким образом, публикация обеспечивает фундаментальное понимание работы с Airflow, способствуя улучшению процессов обработки данных в различных организациях.

Материалы и методы исследования

В исследовании основное внимание уделяется представлению инструментов, данных и методических подходов, необходимых для изучения автоматизации обработки данных.

Установка и подготовка рабочей среды являются первым шагом. Это включает создание виртуальной среды для изоляции зависимостей проекта и настройку базы данных, которая будет служить для отслеживания прогресса выполнения задач. Акцентируется внимание на методике создания эффективных направленных ациклических графов (DAGs), что является основой для определения задач ETL, их взаимосвязей и параметров выполнения.

Особое внимание уделяется выбору и конфигурированию операторов Airflow, которые отвечают за различные этапы процесса ETL, начиная от извлечения данных и заканчивая их загрузкой.

Результаты исследования

В эпоху цифровизации, когда объемы данных увеличиваются ежедневно, их эффективное управление становится жизненно важным аспектом для успеха компаний. Это выделяет критическую роль автоматизированных ETL-процедур (Extract, Transform, Load), которые не только способствуют извлечению данных из многообразия источников, но и их преобразованию в соответствии с корпоративными потребностями, а также загрузке этих данных в централизованные системы для глубокого анализа. Apache Airflow, будучи открытым инструментом для организации рабочих процессов, выступает в качестве эффективного решения для автоматизации таких ETL-операций.

Apache Airflow представляет собой инновационную платформу, разработанную для упрощения и автоматизации сложных рабочих процессов, включая программирование, планирование и мониторинг. Этот инструмент открытого кода ориентирован на управление процессами обработки данных и интеграции систем, предоставляя разработчикам гибкие возможности для организации задач.

В таблице ниже представлены ключевые особенности Apache Airflow, которые делают этот инструмент важным выбором для автоматизации и управления рабочими процессами данных.

Таблица

Ключевые особенности Apache Airflow

|

Особенность |

Описание |

|---|---|

|

Направленные ациклические графы (DAGs) |

Airflow позволяет создавать и управлять рабочими процессами в виде DAGs, где каждый узел представляет задачу, а ребра указывают на зависимости между этими задачами, определяя таким образом последовательность их выполнения. |

|

Гибкость и масштабируемость |

Благодаря поддержке различных исполнителей и интеграции с облачными сервисами, Airflow обеспечивает высокую гибкость и способен масштабироваться для обработки больших объемов данных. |

|

Поддержка множества операторов |

Airflow предоставляет широкий спектр операторов для выполнения разнообразных задач, от запуска скриптов до интеграции с внешними системами и API, что делает его удобным инструментом для реализации комплексных рабочих процессов. |

|

Планирование и мониторинг |

Инструмент обладает встроенными механизмами для планирования задач и мониторинга их выполнения, предоставляя пользователю подробную информацию о статусе каждой задачи и возможность визуализации рабочих процессов. |

|

Устойчивость и восстановление |

Airflow спроектирован для обеспечения устойчивости рабочих процессов, предлагая функциональность для автоматического повторного запуска задач в случае их сбоя, что способствует надежности и минимизации простоев. |

Эти особенности делают Apache Airflow мощным и надежным решением для управления сложными рабочими процессами и автоматизации ETL-операций в различных сферах деятельности.

Apache Airflow, благодаря своей универсальности и масштабируемости, стал важным инструментом для автоматизации и управления рабочими процессами в широком спектре отраслей. Рассмотрим несколько конкретных примеров его применения в реальных проектах [1, c. 68].

В финансовом секторе, где требуется высокая точность и надежность данных, Airflow используется для автоматизации процессов финансового моделирования, риск-менеджмента и отчетности. Компании применяют Airflow для обработки и анализа больших объемов финансовых данных, извлекаемых из различных источников, для принятия обоснованных инвестиционных решений и управления рисками. Airflow позволяет автоматизировать ежедневные процессы сбора данных, их очистку и трансформацию, а также запускать сложные финансовые модели на регулярной основе.

Для компаний электронной коммерции, обрабатывающих огромные массивы данных о покупках, взаимодействиях с клиентами и логистике, Airflow обеспечивает инструменты для автоматизации маркетинговых кампаний, управления запасами и оптимизации цепочек поставок. С помощью Airflow можно автоматизировать процессы сегментации клиентов, анализа поведения покупателей и эффективности рекламных кампаний, что способствует увеличению конверсии и повышению удовлетворенности клиентов.

В области научных исследований Airflow применяется для автоматизации процессов сбора, обработки и анализа экспериментальных данных. Ученые и исследователи используют Airflow для управления сложными рабочими процессами, включающими выполнение компьютерных симуляций, обработку изображений и анализ геномных данных. Это облегчает обработку больших наборов данных, сокращает время на исследования и способствует более быстрому получению результатов.

В индустрии медиа и развлечений, где требуется обработка больших объемов мультимедийного контента и анализ данных пользователей, Airflow помогает автоматизировать процессы куратирования контента, персонализации предложений и аналитики предпочтений аудитории. Компании используют Airflow для управления рабочими процессами, связанными с обработкой видео и аудио, а также для анализа взаимодействий пользователей с платформой, что позволяет повысить вовлеченность аудитории и оптимизировать стратегии контент-маркетинга.

Apache Airflow демонстрирует свою ценность в разнообразных отраслях, предоставляя мощные средства для автоматизации и управления рабочими процессами. Его гибкость и масштабируемость делают Airflow идеальным решением для компаний и организаций, стремящихся оптимизировать обработку данных и повысить эффективность операционных процессов, вне зависимости от специфики отрасли [2, c. 131].

Установка и настройка Apache Airflow – это критически важные шаги, которые необходимо выполнить перед началом работы с этой мощной платформой управления рабочими процессами. Процесс подготовки среды и настройки может варьироваться в зависимости от операционной системы и предпочтений разработчика, но основные этапы остаются общими для всех.

1. Создание виртуальной среды Python

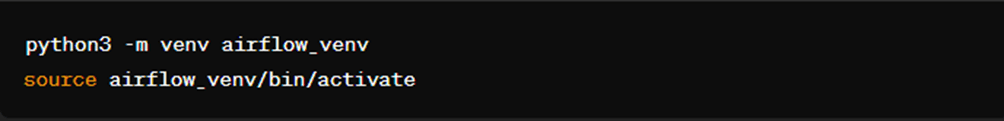

Первым шагом является создание среды Python. Для создания виртуальной среды выполните следующие команды в терминале (рисунок 1):

Рис. 1

Рис. 1

Эти команды создают и активируют виртуальную среду под названием airflow_venv.

2. Установка Apache Airflow

После создания и активации среды можно перейти к установке Apache Airflow. Установка производится через pip менеджера пакета Python. Используйте такие компоненты, которые необходимы для оптимизации производительности и устранения ненужных зависимостей. Например, для установки (рисунок 2):

Рис. 2

Рис. 2

Для установки с поддержкой конкретной базы данных (например, PostgreSQL) используйте (рисунок 3):

Рис. 3

Рис. 3

3. Настройка базы данных

Airflow использует ресурсы для хранения метаданных о рабочих процессах, таких как состояние выполнения задач и история запусков. По умолчанию Airflow настроен на использование SQLite, однако в целях сохранения окружающей среды рекомендуется использовать более мощные СУБД, такие как PostgreSQL или MySQL [3, c. 112].

Для настройки Airflow с PostgreSQL выполните следующие шаги:

- Установите PostgreSQL и создайте базу данных для Airflow.

- Откройте файл конфигурации airflow.cfg и перейдите в секцию [core].

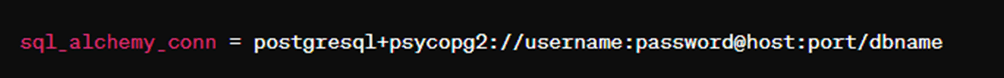

- Измените параметры sql_alchemy_conn подключения к вашей базе данных PostgreSQL, например (рисунок 4):

Рис. 4. Настройка Airflow с PostgreSQL

Рис. 4. Настройка Airflow с PostgreSQL

После изменений задумайтесь о создании базы данных Airflow, запустив (рисунок 5):

Рис. 5. Настройка Airflow с PostgreSQL

Рис. 5. Настройка Airflow с PostgreSQL

Это создаст необходимую команду таблицы и настройки в указанной базе данных.

4. Запуск веб-сервера и планировщика

После настройки данных базы данных запустите веб-сервер Airflow командой (рисунок 6):

Рис. 6. Настройка Airflow с PostgreSQL

Рис. 6. Настройка Airflow с PostgreSQL

Затем в новом терминальном окне активируйте планировщик Airflow (рисунок 7):

Рис. 7. Настройка Airflow с PostgreSQL

Рис. 7. Настройка Airflow с PostgreSQL

Теперь Airflow должен быть полностью настроен и готов к работе. Эти шаги предназначены для начала работы с Apache Airflow. После установки и настройки настроек вы сможете создавать и отслеживать сложные рабочие процессы, оптимизируя и автоматизируя обработку данных в вашей организации [4, c. 126].

Создание первого направленного ациклического графа (DAG) в Apache Airflow является необходимым шагом в изучении управления различными процессами с помощью этой платформы. DAG в Airflow – это набор задач, выполнение которых следует выполнять по последовательности, с учетом их зависимостей. Давайте разберем процесс создания первого шага DAG.

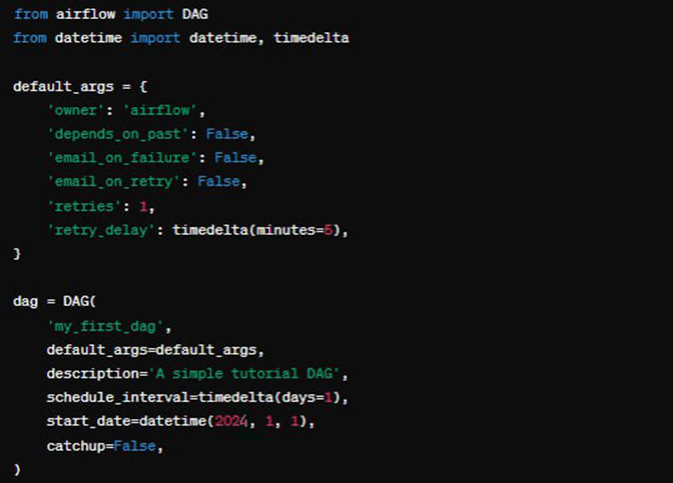

Шаг 1: Определение объекта DAG

Первым делом необходимо определить объект DAG, который будет служить контейнером для ваших задач. В зависимости от DAG вы указываете его уникальный идентификатор, расписание, в котором он будет выполняться, и другие параметры, такие как параметры по умолчанию для задачи (рисунок 8).

Рис. 8. Пример создания DAG

Шаг 2: Добавление задач

После определения объекта DAG следующим шагом будет добавление задач в этот DAG. Эти задачи выполняются с использованием операторов, которые являются предопределенными шаблонами для различных видов действий. К примеру, оператор Python используется для запуска кода на Python, а оператор Bash предназначен для выполнения команд в командной строке.

Шаг 3: Установка зависимостей между задачами

После того как задачи добавлены, вам необходимо определить порядок их выполнения, установленный в зависимости.

После добавления всех необходимых задач и установки зависимостей между ними, ваш DAG готов к выполнению. Вы можете активировать его в веб-интерфейсе Airflow и наблюдать за выполнением процесса, а также за выполнением отдельных задач.

Создание DAG в Airflow открывает широкие возможности для автоматизации и управления различными процессами, предоставляя разработчикам мобильных инструментов для эффективной обработки данных.

Веб-интерфейс Apache Airflow выступает в качестве основного инструмента для эффективного управления различными процессами, повышения их прозрачности и контроля. Этот интерфейс обеспечивает простые функции использования, позволяющие пользователям легко запускать, останавливать и перезапускать DAG, улучшая тем самым удобство управления автоматическими процессами без необходимости внесения изменений в код. Ключевым аспектом веб-интерфейса является его способность предоставлять доступ к детализированным логам выполнения задач, что является неоценимым ресурсом для быстрого обнаружения и исправления ошибок, а также для анализа производительности задач. Более того, веб-интерфейс оснащен мощными аналитическими инструментами, которые позволяют глубоко анализировать выполнение процессов, выявлять проблемные области и определять задачи, требующие больше времени на выполнение. Это обеспечивает не только оптимизацию рабочих процессов, но и в значительной степени обеспечивает их эффективность. Помимо этого, пользователи получают доступ к обширным метаданным и статистическим данным, включая информацию о времени запуска, надежности задач и деталях возникших ошибок, что обеспечивает высочайшую надежность и производительность обработки данных. По сути, веб-интерфейс Apache Airflow представляет собой незаменимый инструмент для глубокого понимания и тщательного контроля над ETL-процессами, позволяющий более эффективно и упростить управление данными [5, c. 187].

Выводы

Apache Airflow представляет собой мощную и гибкую платформу для автоматизации, планирования и рабочих процессов, особенно в области обработки и перемещения данных. Ее возможность организовать задачи в управляемых, направленных ациклических графах (DAG) обеспечивает ясную визуализацию зависимостей и выполнения потоков, что делает ее исправление возможным для сложных ETL-операций. Благодаря поддержке различных баз данных и взаимодействию с постоянно активными сервисами, Apache Airflow обеспечивает высокую масштабируемость и гибкость, позволяя разработчикам создавать кастомизированные рабочие процессы в соответствии с требованиями их проектов. Установка и настройка, хотя и требуют начальной настройки и понимания компонентов, предоставляют широкие возможности для оптимизации процессов обработки данных. Возможность легко создавать, отслеживать и управлять DAG через веб-интерфейс, что значительно упрощает работу с данными, предоставляя инструменты для детального анализа и устранения ошибок.

В свою очередь, применение Apache Airflow в отдельных проектах обеспечивает его универсальность и ценность в различных отраслях – от финансовой и электронной коммерции до научных исследований и средств массовой информации. Эффективное управление данными, автоматизация рутинных задач и оптимизация рабочих процессов – основные преимущества Apache Airflow, делающие его незаменимым инструментом для компаний, стремящиеся улучшить свои возможности в области обработки и анализа данных.

.png&w=640&q=75)