Введение

В условиях современной цифровой экономики способность организации оперативно адаптироваться к изменяющимся рыночным требованиям и обеспечивать высокий уровень пользовательского опыта (UX) выступает ключевым детерминантом конкурентоспособности [5]. Указанное давление проявляется в двух взаимосвязанных, но нередко конфликтующих вектрах: с одной стороны, сохраняется необходимость поддержания высокой скорости вывода новых функциональных возможностей на рынок (TTM), а с другой – нарастает потребность в капитальной реконструкции устаревших монолитных архитектур, отягощенных техническим долгом [1, с. 109-113]. Технический долг, понимаемый как отложенная стоимость неоптимальных архитектурных решений, является неизбежным следствием эволюции программных систем, однако его неконтролируемое накопление прямо коррелирует с ростом затрат на сопровождение, деградацией показателей Developer Experience (DX) и, в конечном счете, с ухудшением финансовых результатов [6, с. 1-32]. Отраслевые отчеты за 2024 год демонстрируют, что организации, реализующие проактивный подход к управлению техническим долгом, направляют на его сокращение до 15 % ИТ-бюджета, трактуя эти затраты как управляемую цену за поддержание гибкости и инновационного потенциала [6, с. 1-32].

В области фронтенд-разработки технический долг материализуется прежде всего в неудовлетворительных значениях метрик Core Web Vitals (CWV), таких как Largest Contentful Paint (LCP), First Input Delay (FID) и Cumulative Layout Shift (CLS) [2, с. 198-205]. Эти метрики, введенные Google в 2020 году, выполняют функцию стандартизированных индикаторов качества взаимодействия пользователя с веб-приложением, обеспечивая сопоставимость систем по ключевым характеристикам воспринимаемой производительности и стабильности интерфейса [8]. Эмпирические исследования, особенно в сегменте электронной коммерции, обнаруживают устойчивую и статистически значимую связь между ухудшением UX, измеряемым через CWV, и снижением коэффициента конверсии при одновременном росте показателя отказов [2, с. 198-205]. Таким образом, архитектурная деградация фронтенда, опосредованная накоплением технического долга, напрямую трансформируется в потери на уровне продуктовых и бизнес-метрик.

В ответ на совокупность данных вызовов организации инициируют масштабные проекты переписывания или реплатформинга фронтенда, переходя от монолитных решений к более гибким и модульным архитектурам, таким как микрофронтенды (MF) [9, с. 62-67]. Несмотря на ожидаемые долгосрочные эффекты в виде повышения адаптивности, масштабируемости и управляемости системы, подобная миграция характеризуется крайне высоким уровнем операционного риска. Центральная проблема заключается в обеспечении непрерывности продуктового цикла и сохранении статистической валидности A/B-тестирования в ситуации, когда унаследованные и вновь создаваемые компоненты фронтенда вынужденно сосуществуют на одном производственном контуре [10]. Любые нарушения рандомизации либо несоблюдение консистентности пользовательских когорт приводят к искажению результатов экспериментов и формированию невалидных выводов, что подрывает культуру принятия решений, основанную на данных, и снижает доверие к экспериментальной инфраструктуре [11].

Теоретические основы контролируемого экспериментирования, в том числе A/B-тестирования как метода изучения пользовательского опыта и инструмента статистически обоснованного принятия продуктовых решений, получили широкое развитие в академической литературе [13, с. 6434-6453]. A/B-тесты рассматриваются как упрощенная форма рандомизированного контролируемого эксперимента, ориентированного на сравнение двух и более вариантов целевой переменной с целью оценки их относительной эффективности [13, с. 6434-6453]. В инженерии программного обеспечения параллельно исследуются подходы к управлению рисками разработки (RRM) и реализации стратегий непрерывного развертывания (CD), обеспечивающих высокую частоту и предсказуемость поставок изменений [15, с. 264-273]. Ключевым инструментом обеспечения контролируемого выпуска функциональности выступают Feature Flags (FF), позволяющие развести во времени процесс развертывания кода и его фактическую активацию для конечных пользователей, а также реализовать практики Dark Launching (развертывание кода в продакшн без его визуальной экспозиции) и Canary Testing (постепенное включение функциональности для ограниченного сегмента аудитории) [4, с. 38-49]. Исследования подтверждают, что FF обладают критическим значением для ускорения TTM и снижения рисков, поскольку предоставляют возможность оперативного отката изменений при выявлении аномалий, не требуя полной пересборки и повторного развертывания системы [19, с. 233-242]. При этом функциональное предназначение FF принципиально различается в зависимости от контекста использования: механизмы Canary Testing преимущественно ориентированы на управление стабильностью и операционными рисками, тогда как A/B-тестирование сфокусировано на валидации метрик и анализе пользовательского поведения [21].

В условиях архитектурной миграции общепризнанным способом снижения рисков является применение паттерна Strangler Fig (SF) [3]. Данный подход, изначально сформулированный Мартином Фаулером, предполагает поэтапную, инкрементальную замену фрагментов монолитной системы новыми компонентами, которые в контексте фронтенда часто реализуются в виде микрофронтендов [22]. Архитектура MF способствует независимому развертыванию модулей, повышению степени модульности и изоляции отказов, что в значительной мере упрощает организацию A/B-тестирования, локализуя потенциальные регрессии в пределах отдельных компонентов [9, с. 62-67]. Вместе с тем, несмотря на детальную проработку контролируемого экспериментирования, FF-практик и миграционных паттернов по отдельности, сохраняется выраженный методологический разрыв: отсутствует интегральная модель, описывающая, каким образом обеспечивается статистическая целостность экспериментальных когорт в ситуации, когда применение SF формирует среду с двумя потенциально несинхронизированными кодовыми базами – легаси-монолитом и новым MF-компонентом.

В обозначенных условиях формируется исследовательская цель, заключающаяся в разработке методологического и архитектурного подхода к организации A/B-тестирования, способного одновременно обеспечивать статистическую целостность экспериментов и непрерывность продуктового цикла в процессе поэтапного переписывания фронтенда, при одновременном снижении операционных рисков. Для достижения указанной цели требуется, во-первых, систематизировать архитектурные паттерны миграции фронтенда и проанализировать их критическую роль в обеспечении физического сосуществования нескольких кодовых баз, необходимого для корректного проведения A/B-экспериментов; во-вторых, разработать концептуальную модель, описывающую механизм маршрутизации трафика и управления когортами экспериментов путем интеграции Feature Flagging и централизованной идентификации пользователей в рамках специализированного Statistical Integrity Layer; в-третьих, выполнить комплексный анализ ключевых операционных, статистических и бизнес-рисков, возникающих при проведении A/B-тестов в мигрирующей архитектурной среде, и предложить матрицу стратегий их смягчения; в-четвертых, продемонстрировать количественную связь между архитектурными улучшениями (сокращение технического долга, оптимизация Core Web Vitals) и ростом продуктовых показателей (коэффициент конверсии, TTM) на основе данных прикладных кейс-стади.

В рамках данной проблематики формулируется научная новизна исследования, заключающаяся в первичном предложении и теоретическом обосновании архитектурной модели «двухдвигательной экспериментации», обеспечивающей непрерывность валидного A/B-тестирования на уровне пользовательских когорт при параллельном существовании и поэтапной замене фронтенд-компонентов.

В качестве авторской гипотезы выдвигается положение о том, что централизованное управление идентификацией пользователя и распределением трафика через единый фасад, находящийся под контролем платформы Feature Flagging, позволяет сохранять статистическую целостность A/B-тестов, снижать совокупные риски и ускорять монетизацию архитектурной миграции.

Материалы и методы

Исследование опирается на фундаментальные положения инженерии программного обеспечения и на методологию controlled delivery, интерпретируемую как совокупность процессов, обеспечивающих управляемое и поэтапное выведение изменений в продуктивную среду. В контексте DevOps и Continuous Development (CD) управление рисками (RRM) должно адаптироваться к высокой динамике изменений, что предполагает встраивание механизмов RRM непосредственно в конвейер развертывания [16]. Техники контролируемого развертывания, такие как Canary Testing и Dark Launching, выполняют роль первичных инструментов снижения операционных рисков, связанных с выводом нового программного обеспечения в эксплуатацию [4, с. 38-49]. В отличие от A/B-тестирования, ориентированного на оценку влияния изменений на бизнес-метрики, Canary-тесты служат для проверки операционной стабильности и производительности нового кода на ограниченной, целенаправленно отобранной подвыборке пользователей, предшествуя запуску полноценного A/B-эксперимента, сфокусированного на сравнении продуктовой эффективности альтернативных версий [21].

В архитектурном измерении ключевое значение приобретает паттерн Strangler Fig (SF), выполняющий функцию опорного механизма для инкрементальной миграции систем. Его применение позволяет избежать стратегии «большого взрыва», предполагающей одномоментную полную замену системы и, соответственно, сопряженной с чрезвычайно высоким уровнем риска [3]. SF обеспечивает контролируемое сосуществование старого и нового кода, что является необходимым условием для корректной организации A/B-тестов в ходе миграции. Переход к архитектуре микрофронтендов (MF) выступает естественным продолжением логики SF, поскольку MF обеспечивают модульность и независимость команд при разработке, тестировании и развертывании отдельных компонентов, что приводит к существенному сокращению TTM [9, с. 62-67]. Дополнительным преимуществом подобной архитектуры является изоляция кода на уровне компонента, позволяющая локализовать ошибки и осуществлять откат изменений без затрагивания всей системы, тем самым снижая риски регрессий и упрощая эксплуатационные процедуры [23].

Методологический аппарат исследования сформирован на основе сочетания нескольких взаимодополняющих подходов. Систематический обзор литературы (SLR) использован для сбора, отбора и анализа актуальных научных данных, преимущественно из ведущих инженерных и компьютерно-научных изданий (IEEE, ACM). При интерпретации полученных результатов дополнительно учитывались аналитические отчеты Gartner и Accenture, предоставляющие прикладной контекст по управлению техническим долгом и стратегиям модернизации корпоративных ИТ-ландшафтов. Сравнительный анализ и классификация применялись для детального сопоставления характеристик архитектурных подходов (монолитная архитектура и MF) и техник controlled delivery (A/B testing и Canary Release), что позволило выявить необходимость не изолированного использования указанных инструментов, а их последовательной и интегрированной комбинации. Метод кейс-стади был задействован для анализа количественных метрик (LCP, TTM, конверсия) на основе обобщенных эмпирических данных, демонстрирующих бизнес-ценность архитектурных улучшений и позволяющих выявлять причинно-следственные связи в условиях сложных системных трансформаций [26].

Собранные материалы были последовательно отсортированы и синтезированы с целью построения целостной архитектурной модели, способной одновременно решать задачи миграции, риск-менеджмента и экспериментирования. В ходе этого анализа выявлен критический методологический аспект – необходимость четкого разграничения целевых установок Canary Testing и A/B Testing. В случае применения Canary Testing на основе Feature Flags ключевым фокусом становится проверка операционной стабильности новой, переписанной версии компонента (V2), тогда как A/B-тест нацелен на сопоставление ее продуктовой эффективности с легаси-версией (V1) в терминах пользовательских и бизнес-метрик. Отсюда вытекает требование, согласно которому система Feature Flags должна одновременно поддерживать контроль стабильности и управлять распределением когорт в рамках статистического эксперимента, обеспечивая согласованность маршрутизации трафика и целостность экспериментального дизайна.

Результаты и обсуждения

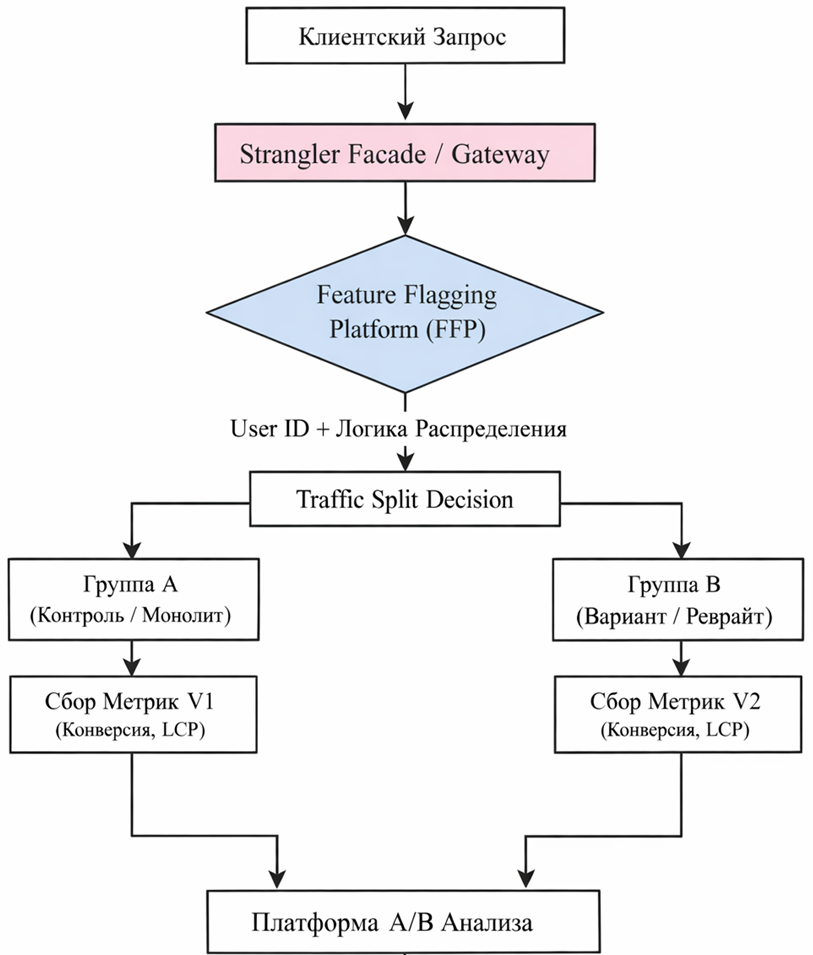

Ключевым результатом проведенного исследования выступает архитектурная модель «Двухдвигательной Экспериментации» (DEE), обеспечивающая статистическую чистоту экспериментов за счет использования паттерна Strangler Fig (SF) в роли фасада, отвечающего одновременно за маршрутизацию трафика и централизованное управление экспериментальными когортами. В рамках данной модели, визуализированной на рисунке 1, решается фундаментальная проблема сосуществования двух кодовых баз: принятие решения о том, какая версия фронтенда будет отображена конкретному пользователю (V1 или V2), осуществляется в единой, надежной точке контроля.

В архитектуре DEE Strangler Facade, размещенный на пограничном уровне системы, играет роль арбитра входящих клиентских запросов и при их обработке инициирует взаимодействие с Центральной Платформой Feature Flagging (FFP). Необходимым условием корректности принимаемых решений является консистентная идентификация пользователя: фасад отвечает за генерацию и персистентное хранение уникального идентификатора (User ID), формируемого, например, на основе IP-адреса, cookie или аутентификационных данных. Этот идентификатор становится опорной сущностью для всех последующих решений FFP. На его основе FFP реализует диспетчеризацию экспериментов и принимает решение об аллокации трафика, определяя принадлежность к контрольной когорте (V1) либо к вариационной когорте (V2). Принципиально важно, чтобы назначение когорты оставалось консистентным на протяжении всей сессии и всех взаимодействий пользователя с системой. Централизация этого решения на уровне шлюза исключает ситуацию, при которой отдельные части интерфейса или независимые компоненты присваивают одному и тому же пользователю различные версии, что неизбежно приводит к смещению выборки и подрыву статистической валидности эксперимента [19, с. 233-242].

Рис. 1. Схема архитектуры «эксперимента с двумя двигателями» (DEE) (составлено автором на основе [19, с. 233-242])

Обеспечение статистической целостности A/B-тестирования в условиях архитектурной миграции требует строгого соблюдения принципов рандомизации и консистентности на уровне пользовательских когорт. Критическим аспектом выступает предотвращение смещения выборки, возникающего в тех случаях, когда распределение пользователей по группам V1 и V2 носит неслучайный характер либо когда состав этих групп изменяется в ходе эксперимента. Типичная ситуация связана с тем, что новый компонент V2 демонстрирует повышенную частоту ошибок или оказывается частично несовместимым с отдельными браузерами и устройствами; в этом случае пользователи, попавшие в вариационную когорту, могут чаще сталкиваться с отказами и преждевременно прекращать взаимодействие с системой. Если аналитическая платформа не учитывает подобное «выбывание» (dropout), формируются систематические искажения: результаты для V2 могут быть искусственно занижены при преимущественном выпадении лояльных пользователей или, напротив, завышены в случае, когда выбывают только нецелевые или малоконверсионные сегменты. Централизованное принятие решения о закреплении пользователя за конкретной группой на уровне FFP, реализуемой во взаимодействии со Strangler Facade, обеспечивает неизменность когортной принадлежности в течение всего периода эксперимента, что является необходимым условием статистической чистоты. Дополнительно требуется использование процедур верификации полноты и согласованности данных (completeness and consistency verification), направленных на подтверждение того, что потоки данных, формирующиеся со стороны V1 и V2, не содержат существенных потерь, асимметрии или структурных несоответствий [30, с. 64-74].

В рамках модели DEE выбор метода распределения трафика рассматривается как управляемый инструмент, позволяющий балансировать между строгостью статистического вывода и скоростью миграции. Простейшей формой является ручная аллокация, при которой доли трафика фиксируются на весь период эксперимента, например 50/50 для классического A/B-теста или 10/10/80 для конфигурации A/B/Control [31]. Подобный режим особенно целесообразен при проверке фундаментальных архитектурных гипотез (сопоставление V1 и V2), поскольку гарантирует достаточный размер выборок и предсказуемость статистической мощности теста. На поздних стадиях миграции, когда гипотеза о превосходстве V2 над V1 уже имеет первичное подтверждение, возможен переход к автоматической аллокации на основе методов класса Multi-Armed Bandit (MAB). В этом случае распределение трафика динамически смещается в пользу варианта, демонстрирующего лучшие продуктовые метрики (например, более высокий коэффициент конверсии), что позволяет ускорить монетизацию результатов рефакторинга и уменьшить время, в течение которого часть аудитории остается на субоптимальной архитектуре [31].

Отдельный пласт рисков связан не с архитектурной или операционной составляющей, а с недостаточным уровнем понимания статистических принципов интерпретации экспериментов. Промежуточный мониторинг результатов (interim monitoring) и преждевременная остановка теста («peeking») без применения корректировок на множественные сравнения приводят к некорректной оценке эффектов и завышению вероятности ошибок I рода [12, с. 1806-1821]. Эмпирические исследования индустриальных A/B-платформ показывают, что использование наивных стратегий мониторинга, даже при больших объемах трафика, ведет к плохо функционирующим исследованиям и неспособности надежно отличать истинные эффекты от статистического шума [11]. Для смягчения данного класса рисков в методологии DEE предполагается использование формальных корректирующих процедур, таких как границы О’Брайена–Флеминга, позволяющих проводить серию промежуточных проверок при сохранении контролируемых уровней ошибок I и II рода. Подобные подходы создают дисциплинирующую рамку для управленческих решений, снижая вероятность преждевременного завершения эксперимента до достижения минимально необходимого размера выборки и тем самым поддерживая статистическую валидность выводов [11].

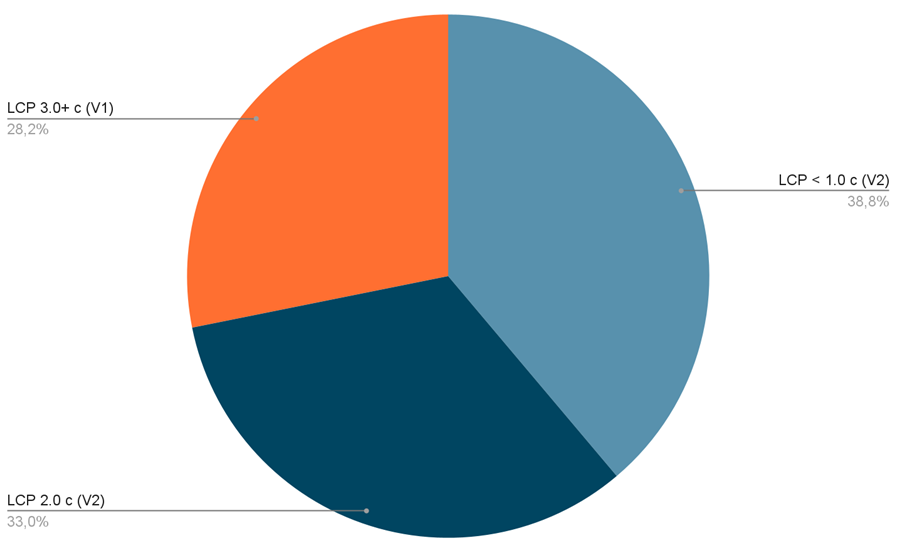

Количественная оценка выгод архитектурной миграции в модели DEE опирается на анализ взаимосвязи между улучшением технических метрик и динамикой продуктовых показателей. Переход к модульным, высокопроизводительным фронтенд-архитектурам и фреймворкам оказывает прямое воздействие на метрики Core Web Vitals (CWV), что в свою очередь отражается на поведении пользователей и финансовых результатах. Среди метрик CWV особое место занимает Largest Contentful Paint (LCP), рассматриваемый как один из наиболее чувствительных индикаторов воспринимаемого UX и вовлеченности. Исследования демонстрируют, что ускорение загрузки имеет нелинейное, но чрезвычайно сильное влияние на конверсию [5]. В сегменте онлайн-ритейла, где скорость взаимодействия напрямую связана с вероятностью завершения транзакции, наблюдаются значительные перепады конверсии: при LCP менее 1 секунды она может достигать порядка 40%, тогда как при увеличении LCP свыше 3 секунд значение снижается до 29% [5]. Это указывает на то, что архитектурные улучшения, направленные на снижение технического долга и оптимизацию рендеринга – например, внедрение серверного рендеринга (SSR), переразбиение и оптимизация JavaScript-пакетов, сокращение блокирующих ресурсов, – обладают прямым экономическим эффектом. В одном из проанализированных кейсов уменьшение LCP с 3,8 до 2,2 секунды, достигнутое за счет комплексной оптимизации фронтенд-архитектуры, привело к росту продаж на 12% [2, с. 198-205].

Использование A/B-тестирования в рамках DEE позволяет формализовать и количественно измерить подобные эффекты, сопоставляя значения LCP и конверсии для компонента, работающего в легаси-архитектуре (V1), и его рефакторинговой версии (V2). Такая постановка эксперимента дает возможность оценивать возврат инвестиций (ROI) в архитектурную модернизацию не в абстрактных терминах «улучшения UX», а в форме прямого влияния на ключевые бизнес-метрики. Концептуальное и графическое представление зависимости конверсии от LCP и эффектов миграции между V1 и V2 иллюстрируется на рисунке 2, где демонстрируется, как смещение распределения LCP в область более низких значений приводит к систематическому росту конверсии и, соответственно, к повышению экономической эффективности архитектурных решений.

Рис. 2. Графическое представление влияния улучшения метрики Largest Contentful Paint (LCP) на коэффициент конверсии (составлено автором на основе [5]).

Сокращение Time to Market (TTM) в условиях архитектурной миграции непосредственно связано с переходом к модульной архитектуре микрофронтендов, достигаемой с использованием паттерна Strangler Fig. Разделение фронтенда на независимые доменно-ориентированные модули устраняет жесткие междисциплинарные и межкомандные зависимости, характерные для монолитных систем, и позволяет командам разрабатывать, тестировать и развертывать компоненты параллельно [24]. В отличие от монолита, где даже незначительное изменение требует прохождения через полный цикл сборки, интеграции и регрессионного тестирования всей системы, микрофронтендная архитектура дает возможность локализовать изменения в пределах одного модуля. Это снижает координационные издержки, уменьшает объем обязательной интеграционной валидации и, как следствие, приводит к систематическому сокращению TTM при выпуске инкрементальных улучшений [33].

Feature Flags усиливают данный эффект, формируя дополнительный уровень гибкости на стыке разработки и эксплуатации. Использование флагов позволяет отказаться от длительной работы с длинноживущими ветками кода и сложных процедур их слияния, сохраняя изменения в основной ветке и контролируя их экспозицию исключительно на уровне конфигурации [20]. Команда может развернуть новую функциональность (V2) в продуктивной среде в режиме Dark Launching, когда код уже присутствует в системе, но остается скрытым от конечных пользователей до момента принятия решения об активации. Включение функции может быть синхронизировано с запуском A/B-теста, что позволяет одновременно проверить как техническую устойчивость, так и продуктовый эффект нововведения [18]. Тем самым достигается разрыв жесткой связи между развертыванием и релизом: система всегда находится в состоянии, готовом к быстрому включению или откату функциональности, что принципиально повышает скорость итераций и адаптивность продуктового цикла.

Внедрение модели DEE формирует основу для систематизированного управления рисками, возникающими при параллельной эксплуатации двух архитектурных контуров, и предполагает охват не только операционной стабильности, но и статистической валидности экспериментов, а также технического обслуживания самой платформы экспериментирования. Управление рисками в данном контексте опирается на матрицу сценариев и стратегий смягчения, в которой ключевое внимание уделяется поэтапному, контролируемому выводу новой версии компонента (V2) в продуктивную среду. Для минимизации операционного риска, связанного с потенциальной нестабильностью нового фреймворка или компонента, используется последовательная схема развертывания: на первом этапе выполняется Dark Launching, при котором код V2 присутствует в продакшене, но остается деактивированным для конечных пользователей; далее следует стадия Canary Testing, когда функциональность включается для ограниченной доли аудитории (например, порядка 1% пользовательского трафика) [4, с. 38-49]. Лишь после подтверждения того, что внедрение не приводит к росту частоты ошибок, ухудшению латентности или иным значимым деградациям, инициируется полноформатный A/B-тест. В случае выявления аномалий в ходе эксперимента использование Feature Flag позволяет оперативно переключить трафик обратно на версию V1, минимизируя масштабы негативных последствий и сокращая время воздействия проблемного варианта на пользователей.

К числу технических рисков относится управление жизненным циклом Feature Flags. На практике команды разработки часто сталкиваются с накоплением «мертвых» флагов, которые не удаляются после завершения экспериментов или раскатки функциональности и продолжают присутствовать в кодовой базе [34, с. 1411-1425]. Это приводит к формированию специфического «технического долга экспериментирования», усложняет понимание актуального состояния системы, увеличивает когнитивную нагрузку на разработчиков и в конечном итоге негативно влияет на Developer Experience [20]. Для снижения данного вида риска требуется жестко регламентированная политика управления флагами, предполагающая обязательное удаление или консолидацию соответствующего кода в течение короткого, заранее определенного срока после принятия окончательного решения по результатам теста.

Дополнительно учитываются SEO-риски, связанные с тем, что поисковые системы могут индексировать экспериментальные варианты страниц (V2), рассматривая их как отдельные документы, что потенциально приводит к дублированию контента и размыванию релевантности [35, с. 6434-6453]. Смягчение этого класса рисков достигается за счет использования временных редиректов (302) в тех сценариях, где необходимо управлять маршрутизацией трафика, а также строгого применения атрибута rel="canonical", указывающего на оригинальную (каноническую) версию страницы. Такое комбинированное решение позволяет сохранить целостность поисковой индексации, предотвратить возникновение нежелательного дубляжа и избежать искажений в распределении ранжирующих сигналов между экспериментальными и базовыми версиями [35, с. 6434-6453].

Заключение

Проведенное исследование было ориентировано на разработку методологического подхода к организации A/B-тестирования в условиях особенно сложной архитектурной трансформации фронтенд-слоя. В ответ на сформулированную цель предложена и теоретически обоснована модель «Двухдвигательной Экспериментации» (Dual-Engine Experimentation, DEE), основанная на синергетическом сочетании паттерна Strangler Fig и централизованной платформы Feature Flagging. Данная модель задает целостный каркас, в рамках которого архитектурная миграция и продуктовое экспериментирование рассматриваются как взаимосвязанные процессы, требующие единого управленческого и статистического контура.

Одним из ключевых результатов является концепция архитектурной непрерывности. Успешная постановка и проведение A/B-тестов в процессе переписывания фронтенда предполагает наличие фасада (Strangler Facade), функционирующего как единая точка принятия решений и обеспечивающего консистентное распределение пользователей между легаси- и новой кодовыми базами. Переход к микрофронтендам в качестве целевой архитектуры создает необходимую модульность и изоляцию изменений, тем самым снижая координационные издержки и способствуя сокращению Time to Market [23]. Статистическая целостность достигается за счет строгого отделения логики идентификации пользователя и аллокации когорты от логики рендеринга фронтенда, что минимизирует вероятность систематического смещения выборки. Применение формализованных статистических протоколов, включающих, в частности, использование границ О’Брайена–Флеминга, препятствует преждевременной остановке тестов и снижает риск принятия невалидных выводов при промежуточном мониторинге [11]. Управление рисками в рамках DEE организуется как поэтапный процесс: первоначально применяется Canary-тестирование, нацеленное на проверку операционной стабильности и минимизацию технологических угроз, после чего запускаются A/B-эксперименты, ориентированные на оценку бизнес-эффективности и монетизацию улучшений. Feature Flags в этом контуре выступают ключевым инструментом, обеспечивающим гибкое переключение между версиями и возможность мгновенного отката к V1 при обнаружении регрессий [19, с. 233-242]. Количественная монетизация архитектурных изменений подтверждается анализом того, как улучшение технических метрик, в первую очередь снижение LCP, коррелирует с ростом коэффициента конверсии и, следовательно, с ускоренной окупаемостью инвестиций в рефакторинг [2, с. 198-205].

Практическая значимость полученных результатов проявляется в формировании структурированной, опирающейся на эмпирические и теоретические данные методологии, которая может использоваться инженерными и продуктовыми командами при планировании и проведении крупномасштабных архитектурных преобразований без отказа от практики непрерывного принятия решений, основанных на данных. Представленный подход задает конкретные ориентиры для организации фасадного уровня, настройки инфраструктуры Feature Flags, построения экспериментальных когорт и выбора процедур статистического анализа. Теоретическое значение заключается в том, что модель DEE устраняет существующий разрыв между исследованиями в области архитектурных паттернов миграции и методологиями контролируемого экспериментирования, интегрируя их в единый фреймворк, специально сфокусированный на сохранении статистической строгости при параллельной эксплуатации нескольких архитектурных контуров.

Вместе с тем исследование обладает рядом ограничений, обусловленных преимущественно его теоретико-концептуальной направленностью. Описанная модель и предложенные методологические принципы требуют дальнейшей эмпирической валидации в условиях промышленных систем с высокой нагрузкой, где возможно количественно оценить эффективность стратегии риск-менеджмента, устойчивость статистических выводов и фактическую динамику продуктовых метрик при внедрении DEE. Перспективным направлением дальнейших исследований представляется разработка и испытание автоматизированных механизмов управления жизненным циклом Feature Flags (включая процессы Flag Cleanup), призванных предотвращать накопление «технического долга экспериментирования» и обеспечивать долговременную поддерживаемость инфраструктуры контролируемого развертывания и A/B-тестирования.

.png&w=640&q=75)