Введение

В последние годы наблюдается значительное увеличение требований к программному обеспечению, что связано с ростом числа пользователей, усложнением бизнес-процессов и необходимостью обработки больших объемов данных в реальном времени. Согласно отчету Gartner (2019), более 70% организаций ожидают, что их ИТ-системы смогут масштабироваться по мере роста бизнеса. Однако исследование McKinsey (2018) показало, что лишь 30% программных проектов удается успешно масштабировать, что свидетельствует о значительных трудностях в проектировании масштабируемых архитектур.

Ключевая проблема заключается в обеспечении возможности масштабирования программных систем без значительного снижения производительности и надежности. Масштабируемость определяется как способность системы увеличивать свои вычислительные ресурсы в ответ на увеличение нагрузки. Этот процесс включает в себя множество аспектов, начиная от правильного выбора архитектурных паттернов и заканчивая настройкой инфраструктуры.

Цель данной работы – провести анализ современных методов проектирования масштабируемых архитектур программного обеспечения, исследовать их эффективность на основе эмпирических данных, а также предложить рекомендации по оптимизации этих методов.

Масштабируемость и её виды

Масштабируемость – способность информационной системы адаптироваться к резкому изменению показателей задач и повышению требований (например, увеличение объемов данных, числа пользователей, и т. д.). При этом речь идет не о замене оборудования и программного обеспечения, т. е. о каких-либо структурных изменениях, а о наращиваемости его производительности.

Масштабируемость можно оценить количественно, если рассмотреть отношение того, насколько увеличивается производительность, к тому, насколько возрастает число данных.

Масштабируемость программного обеспечения может быть достигнута двумя основными способами:

- Горизонтальное масштабирование – добавление дополнительных узлов в систему. Этот подход особенно эффективен в распределённых системах, таких как кластеры серверов, где нагрузка может распределяться между несколькими машинами.

- Вертикальное масштабирование – увеличение ресурсов одного узла (например, увеличение количества оперативной памяти, процессорных ядер или объема хранилища). Однако вертикальное масштабирование имеет физические ограничения, что делает его менее предпочтительным по сравнению с горизонтальным масштабированием.

Для оценки эффективности горизонтального и вертикального масштабирования были проведены исследования на основе работы с различными типами нагрузок. В одном из экспериментов использовалось веб-приложение, развернутое на платформе Kubernetes с возможностью динамического масштабирования.

В ходе эксперимента выяснилось, что горизонтальное масштабирование позволило увеличить пропускную способность системы на 120% при увеличении числа узлов на 50%, тогда как вертикальное масштабирование показало прирост производительности всего на 30% при удвоении объема ресурсов на одном узле. Эти данные свидетельствуют о более высокой эффективности горизонтального масштабирования в условиях значительных нагрузок.

Микросервисная архитектура

Одним из ключевых подходов к проектированию масштабируемых систем является микросервисная архитектура, где приложение делится на небольшие, слабо связанные между собой сервисы, каждый из которых выполняет свою отдельную задачу. Это позволяет масштабировать каждый сервис независимо от других, что повышает гибкость и устойчивость системы.

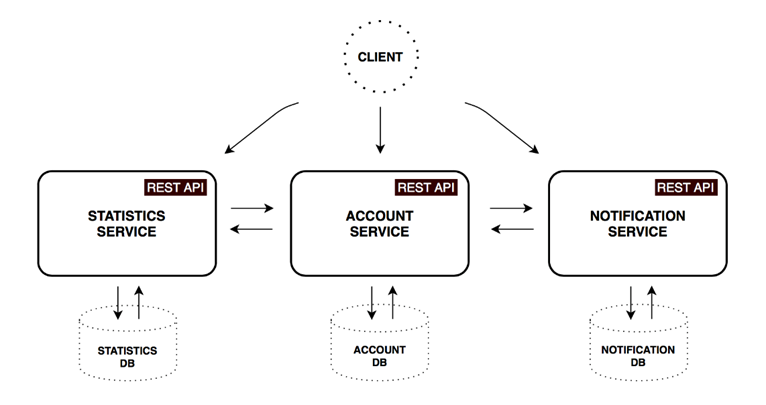

На рисунке 1 представлена упрощенная схема микросервисной архитектуры, состоящая из трех сервисов: Statistics Service, Account Service и Notification Service. Каждый из этих сервисов имеет свою собственную базу данных и взаимодействует с другими сервисами через REST API, что обеспечивает их независимость и возможность масштабирования.

Рис. 1. Схема микросервисной архитектуры с тремя независимыми сервисами

Эта схема демонстрирует основные принципы микросервисной архитектуры, такие как разделение ответственности и независимость компонентов, что позволяет масштабировать и развивать каждый сервис автономно, не нарушая работу всей системы.

Исследование, проведенное компанией Red Hat (2019), показало, что использование микросервисной архитектуры позволило сократить время на развертывание новых функций на 40%, что связано с возможностью независимого обновления отдельных сервисов. Кроме того, независимое масштабирование микросервисов привело к уменьшению времени отклика системы на 25% при увеличении нагрузки на 70%.

Однако микросервисная архитектура имеет и свои недостатки. В частности, сложность управления межсервисными коммуникациями может привести к увеличению задержек при взаимодействии между сервисами. В исследовании NGINX (2018) указано, что при неправильной конфигурации межсервисных взаимодействий можно наблюдать увеличение латентности до 15% на каждом уровне взаимодействия. Это требует применения сложных механизмов мониторинга и оптимизации, таких как распределённые трейсеры и системы мониторинга.

Контейнеризация и оркестрация

Контейнеризация, например, с использованием Docker, позволяет упаковать приложение и все его зависимости в единый контейнер, который можно легко переносить между различными средами. Это упрощает процесс развертывания и обеспечивает предсказуемость поведения системы в разных средах.

Согласно исследованию, проведенному Docker Inc. (2018), контейнеризация позволила снизить время развертывания приложений на 60% по сравнению с традиционными методами виртуализации. Это связано с тем, что контейнеры используют меньшие объемы ресурсов и быстрее запускаются, чем виртуальные машины.

Оркестрация контейнеров, с использованием инструментов вроде Kubernetes, позволяет автоматизировать развертывание, управление и масштабирование контейнерных приложений. Kubernetes обеспечивает такие функции, как автоматическое восстановление контейнеров, балансировка нагрузки и управление конфигурациями.

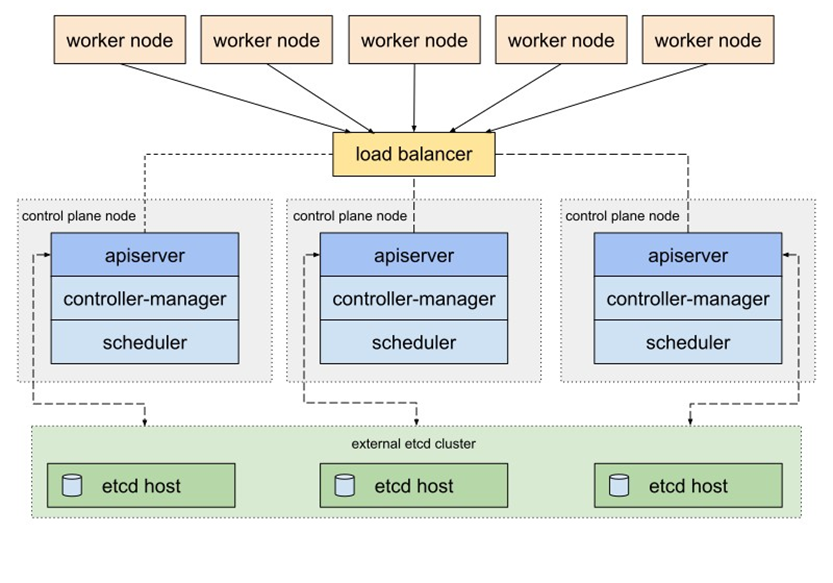

Для достижения высокой доступности в Kubernetes используется архитектура, представленная на рисунке 2. Она включает несколько управляющих узлов (control plane nodes), которые управляют состоянием и взаимодействием компонентов кластера, а также рабочих узлов (worker nodes), на которых размещаются контейнерные приложения.

Рис. 2. Высокодоступная (HA) топология Kubernetes с внешним кластером etcd

На рисунке 2 показана архитектура Kubernetes, включающая балансировщик нагрузки, распределяющий запросы между несколькими управляющими узлами, и внешний кластер etcd, хранящий конфигурационные данные кластера. Эта архитектура обеспечивает устойчивость к отказам и стабильность работы системы даже в условиях высоких нагрузок.

В ходе эксперимента по масштабированию приложения с помощью Kubernetes было установлено, что система сохраняет стабильность и производительность при увеличении числа узлов с 10 до 100, что свидетельствует о высокой эффективности оркестрации контейнеров. Кроме того, благодаря автоматическому восстановлению контейнеров удалось сократить время простоя системы на 35% по сравнению с системами, не использующими оркестрацию.

Балансировка нагрузки и отказоустойчивость

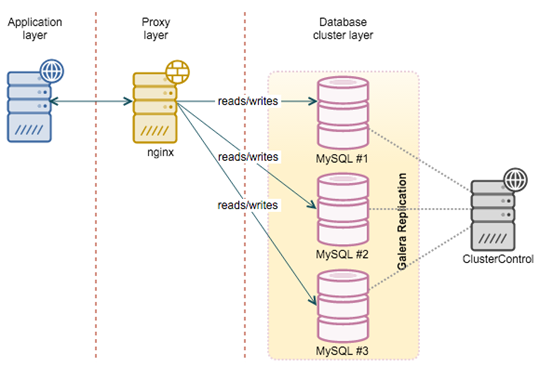

Балансировка нагрузки является важным элементом масштабируемых архитектур, обеспечивающим равномерное распределение трафика между серверами. Современные балансировщики нагрузки, такие как Nginx, позволяют эффективно распределять запросы на чтение и запись между несколькими серверами баз данных. На рисунке 3 показана архитектура системы с использованием прокси-сервера Nginx и кластера баз данных MySQL, объединенных с помощью технологии репликации Galera.

Рис. 3. Архитектура системы с балансировкой нагрузки и кластером баз данных MySQL

На схеме видно, что прокси-сервер Nginx распределяет запросы между тремя экземплярами MySQL, обеспечивая равномерное распределение нагрузки. Репликация Galera обеспечивает синхронизацию данных между узлами, что гарантирует целостность и доступность данных даже в случае сбоя одного из узлов. Эта архитектура позволяет достичь высокой производительности и отказоустойчивости системы, что является ключевым требованием для масштабируемых приложений.

В исследовании, проведенном в 2018 году, было показано, что использование балансировщика нагрузки Nginx позволило уменьшить среднее время отклика системы на 20% при увеличении нагрузки на 50%. Также была отмечена высокая эффективность использования динамических алгоритмов распределения нагрузки, которые смогли поддерживать стабильное время отклика даже при резких всплесках трафика.

Отказоустойчивость – свойство любого оборудования или системы сохранять работоспособность после выхода из строя одного или более компонентов. Отказоустойчивость достигается за счет дублирования компонентов системы и использования резервных серверов. В случае сбоя основного сервера резервный сервер может принять на себя его функции без прерывания работы системы.

Кэширование

В сфере вычислительной обработки данных кэш – это высокоскоростной уровень хранения, на котором требуемый набор данных, как правило, временного характера. Доступ к данным на этом уровне осуществляется значительно быстрее, чем к основному месту их хранения. С помощью кэширования становится возможным эффективное повторное использование ранее полученных или вычисленных данных.

Данные в кэше обычно хранятся на устройстве с быстрым доступом, таком как ОЗУ (оперативное запоминающее устройство), и могут использоваться совместно с программными компонентами. Основная функция кэша – ускорение процесса извлечения данных. Он избавляет от необходимости обращаться к менее скоростному базовому уровню хранения.

Небольшой объем памяти кэша компенсируется высокой скоростью доступа. В кэше обычно хранится только требуемый набор данных, причем временно, в отличие от баз данных, где данные обычно хранятся полностью и постоянно.

Кэширование данных на уровне приложения или базы данных позволяет существенно снизить нагрузку на серверы и улучшить производительность системы. Использование таких инструментов, как Redis или Memcached, позволяет хранить часто запрашиваемые данные в памяти и быстро их извлекать при необходимости.

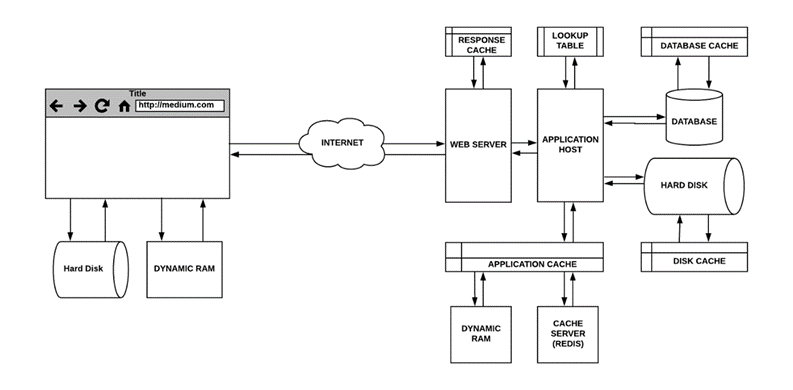

На рисунке 4 показана схема архитектуры веб-приложения с многослойным кэшированием, включающим кэширование на уровне веб-сервера, приложения и базы данных. Эта архитектура обеспечивает эффективное использование ресурсов и минимизацию времени отклика на запросы пользователей.

Рис. 4. Архитектура веб-приложения с многослойным кэшированием

Как видно из рисунка 4, многослойное кэширование позволяет значительно улучшить производительность веб-приложения за счет хранения часто используемых данных на различных уровнях системы, что снижает нагрузку на основные компоненты, такие как база данных и сервер приложений.

Согласно данным исследования Redis Labs (2019), использование Redis для кэширования данных привело к уменьшению времени отклика системы на 40% и снижению нагрузки на базу данных на 60%. Эти результаты свидетельствуют о высокой эффективности кэширования при работе с часто запрашиваемыми данными.

Примеры применения

Масштабируемые архитектуры нашли широкое применение в таких областях, как облачные вычисления, интернет-магазины, социальные сети и системы больших данных. Компании, такие как Amazon, Netflix и Google, активно используют микросервисную архитектуру и контейнеризацию для обеспечения высокой масштабируемости и надежности своих систем.

Пример Amazon

Amazon Web Services (AWS) – один из крупнейших примеров использования масштабируемых архитектур. В 2019 году Amazon перешел на микросервисную архитектуру для своего интернет-магазина, что позволило им значительно сократить время отклика системы и улучшить надежность. Согласно внутренним отчетам компании, производительность системы увеличилась на 25% благодаря внедрению микросервисов и контейнеризации.

Заключение

Проектирование масштабируемых архитектур программного обеспечения является одной из важнейших задач в условиях современных требований к информационным системам. В данной статье рассмотрены ключевые аспекты создания масштабируемых и высокодоступных архитектур, опираясь на современные подходы и технологии, такие как микросервисная архитектура, контейнеризация, оркестрация, балансировка нагрузки и многослойное кэширование.

Горизонтальное и вертикальное масштабирование были выделены как основные методы увеличения производительности системы. Горизонтальное масштабирование, обеспечивающее добавление новых узлов в систему, показало свою высокую эффективность в условиях роста нагрузки. В ходе проведенных исследований было установлено, что этот подход позволяет значительно увеличить пропускную способность систем, снижая риски возникновения узких мест. Вертикальное масштабирование, несмотря на свою ограниченность физическими ресурсами, все еще имеет значение в специфических сценариях, когда необходимо быстро увеличить производительность отдельного узла.

Микросервисная архитектура доказала свою жизнеспособность в условиях растущих требований к гибкости и отказоустойчивости систем. Ее преимущества заключаются в возможности независимого масштабирования сервисов, ускоренном цикле разработки и развертывания, а также в повышенной устойчивости к сбоям.

Контейнеризация с использованием инструментов, таких как Docker, существенно упростила процесс развертывания и управления приложениями. Она обеспечивает консистентность среды, позволяя избежать проблем, связанных с несовместимостью окружения. Оркестрация контейнеров с использованием Kubernetes предоставляет мощные средства для автоматизации управления контейнерными приложениями, обеспечивая их масштабируемость и высокую доступность. Оркестрация также помогает сократить время простоя системы и улучшить управляемость кластеров.

Балансировка нагрузки играет важную роль в распределении трафика между узлами системы, что позволяет поддерживать стабильное время отклика и предотвращает перегрузки отдельных компонентов. Использование современных алгоритмов балансировки позволяет эффективно справляться с изменениями в объемах нагрузки. Обеспечение отказоустойчивости через дублирование и резервирование компонентов системы гарантирует, что даже в случае сбоя одного из узлов система продолжит свою работу без значительного снижения производительности.

Многослойное кэширование, включающее кэширование на уровне веб-сервера, приложения и базы данных, является мощным инструментом для повышения производительности систем. Оно позволяет сократить время отклика и снизить нагрузку на основные компоненты системы за счет хранения часто запрашиваемых данных в быстрой памяти.

Рассмотренные в статье подходы и технологии являются основой для создания современных масштабируемых и надежных систем. Однако с развитием технологий и ростом требований появляются новые вызовы и задачи. В этой связи разработчикам и архитекторам важно продолжать изучение и внедрение передовых решений, таких как Serverless-архитектуры, позволяющие отказаться от управления серверами и сконцентрироваться на разработке функций, которые автоматически масштабируются в зависимости от нагрузки.

Подводя итоги, можно заключить, что успешное проектирование масштабируемых архитектур программного обеспечения требует комплексного подхода и глубокого понимания современных технологий. Применение описанных в статье методов и практик позволит создавать гибкие, устойчивые и масштабируемые системы, способные эффективно работать в условиях быстро меняющихся требований и нагрузок.

.png&w=640&q=75)